Tendencia á diferenciación de xéneros na intelixencia artificial

— Na figura 1 hai dous robots intelixentes, mozo ou moza? Cal é?

— Pero, de que falamos? Como é posible que a intelixencia artificial tenda a diferenciar os xéneros? As máquinas non teñen xénero, non é así?”

Efectivamente. A intelixencia das máquinas é a intelixencia artificial (IA) ou a máquina. Non é novo, porque pasaron moitos anos desde 1956, cando Samuel, Simmons, Newell, MacArthy e Minsky declararon a intelixencia artificial como liña de investigación. Desde entón, a tecnoloxía avanzouse enormemente. Comprender a linguaxe natural, xogar con éxito en xogos que requiren estratexias complexas (xadrez, xogo Go), desenvolver sistemas autónomos de condución e planificar de forma óptima as canles en redes de distribución multipunto son algúns dos avances que foron posibles grazas á AA. Paira iso utilízanse métodos estatísticos e formalismos simbólicos, entre outros. E é que a aprendizaxe automática é o que sustenta a actual revolución da AA. Estes estudos son métodos que derivan do coñecemento de bases de datos grosas e que son utilizados por axencias de compañías e gobernos, hospitais e outras empresas [2] paira aplicacións diversas. Por exemplo, identificar obxectos en secuencias de vídeo, valorar a credibilidade das solicitudes de préstamo, buscar erros nos contratos legais ou atopar o tratamento máis adecuado paira una persoa con cancro [1] [2].

AA xa está no noso día a día, moitas das aplicacións que levamos nos nosos móbiles están baseadas en técnicas de intelixencia artificial (solucións) e usámolas con normalidade. Por exemplo, é cada vez máis frecuente utilizar a comunicación oral paira comunicarse con teléfonos e computadores: Amazon ofrece Alex, Google Home, Apple ofrece Siri e Microsoft Cortana. Estes son os servidores de voz, as ferramentas que nos permiten coñecer, procesar e responder á pregunta ou solicitude realizada, una vez realizada a procura en Internet, mediante a síntese de voz.

Somos conscientes de que, debido ás tendencias dos anos, a propia sociedade non é neutra e que as tendencias na diferenciación de xéneros (e outros) son a miúdo patentes. Por exemplo, o rol do coidado adscríbese ás mulleres e os roles relacionados coa forza aos homes. Pero que pasa coa intelixencia artificial? Se a intelixencia artificial e a aprendizaxe automática evolucionan, córrese o risco de integrar estas tendencias nas ferramentas do futuro. E é que xa está a suceder.

Datos fonte de problemas

Os algoritmos de aprendizaxe automática realizan predicións segundo o apreso. Os propios algoritmos non teñen tendencia nin de xénero, nin de raza, nin doutro tipo. Pero como se mencionou, baséanse en datos, matemáticas e estatística. A tendencia está nos datos, que son reflexo da sociedade e que son froito das nosas decisións. Nos criterios que utilizamos as persoas paira a contratación de candidatos, na avaliación dos informes dos alumnos, na realización de diagnósticos médicos, na descrición dos obxectos, en todos eles temos tendencias de diferenciación entre cultura, raza, educación e outros [5], e entre eles, por suposto, a diferenciación de xéneros. En definitiva, os modelos creados serán tan bos ou neutros como os datos utilizados paira o adestramento no mellor dos casos. Nós recollemos e etiquetamos os datos, reflectimos nosa subjetividad nos datos, o que provoca tendencias nos sistemas desenvolvidos mediante a aprendizaxe automática. É máis, a intelixencia artificial amplifica os estereotipos! [2]. De feito, cando seleccionamos o modelo máis adecuado a partir de algoritmos de aprendizaxe automática, eliximos o que mellor se adapta aos datos ou o que ten maior taxa de invención, deixando de lado outros criterios.

O problema é grave, sobre todo naqueles casos nos que se utiliza paira a toma de decisións o proposto polas máquinas, algo que ocorre con frecuencia na vida cotiá, xa que as ferramentas baseadas na intelixencia artificial están moi estendidas [4].

Algúns exemplos de tendencia á diferenciación de xéneros

Se retrocedemos uns quince anos, cando os primeiros desenvolvementos paira coñecer a fala implantáronse nos coches, os sistemas non entendían as voces femininas, xa que se adestraron coas dos homes. A pesar de que nos últimos anos avanzáronse enormemente neste tipo de sistemas, e que coñecen as voces de mulleres e homes, a tendencia do xénero segue sendo evidente. Ao fío dos servidores de voz que acabamos de mencionar, tres de cada catro teñen nome de muller e, máis aínda, todos teñen voz de muller por defecto. Aínda que hoxe en día pódese cambiar, por defecto os obedecedores que fan de servidores son femininos.

Por que? A razón é sinxela porque esperamos mulleres en tarefas administrativas e en coidados ou servizos. Facer una enquisa non sería de estrañar que a maioría priorizase a voz feminina.

A tendencia á diferenciación de xéneros non só aparece en contextos relacionados coa voz. No procesamiento da linguaxe natural, por exemplo, paira realizar análise semánticos de textos, utilízanse dicionarios grosos, denominados word-embedding, que se extraen de grandes conxuntos de textos e que relacionan as palabras entre si. Un estudo realizado por investigadores da universidade de Boston [2] puxo de manifesto que con estes dicionarios pódense producir inferencias do tipo “John escribe mellores programas que Mary”. Loxicamente, isto é consecuencia dos textos utilizados paira crealos.

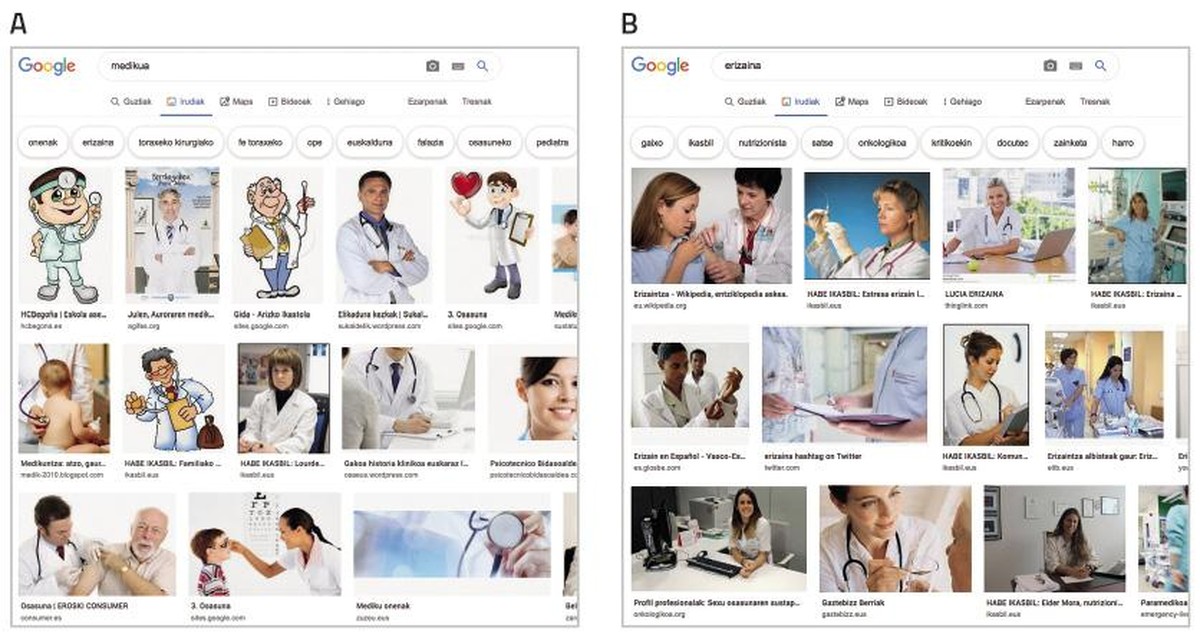

Nunha sociedade dominada pola imaxe, os sistemas que aprenden artificialmente aliméntanse cada vez máis da imaxe. Os coñecidos conxuntos de datos ImSitu (http://imsitu.org/) e COCO (http://cocodataset.org/) conteñen máis de 100.000 imaxes procedentes da rede, etiquetadas con explicacións de escenas complexas [3]. Tanto nun como noutro caso, son máis as figuras masculinas, e constátase que as etiquetas de obxectos e accións tenden a diferenciar os xéneros. No conxunto de datos COCO, os utensilios de cociña (culleres e tenedores) descríbense relacionados coas mulleres, mentres que o equipamento paira deportes ao aire libre (táboas de neve e raquetas de tenis) asócianse aos homes. O mesmo ocorre na base de datos ImageNet, creada entre 2002 e 2004 coas imaxes de Yahoo News, e aínda moi utilizada. O 78% das imaxes están representadas por homes e o 84% delas con cortiza branca, xa que George W. Bush é a persoa que máis aparece. Como estes conxuntos de datos utilízanse paira adestrar software de recoñecemento de imaxes, o software herdará a tendencia. Proba, busca o “médico” nas imaxes de Google e a pantalla énchese de homes vestidos con delantales brancos. Pola contra, se buscas “enfermeira”, destacaranche as mulleres (ver figura 2).

Vías paira eliminar a tendencia

Para que as propostas de sistemas de intelixencia artificial sexan fiables, deberiamos primeiro asegurar que as propostas son obxectivas. Os algoritmos non teñen conciencia e por tanto non poden cambiar as súas propostas.

A forma de afrontalo non é a única; pode e debe abordarse desde moitas frontes.

Por unha banda, será imprescindible a participación activa das mulleres en todos os pasos do desenvolvemento tecnolóxico. Segundo as estatísticas, as mulleres están cada vez máis afastadas do 50% en postos de tecnoloxía informática. A pesar de que o cambio vai axudar, isto non garante que nos sistemas que se vaian a crear desaparezan as tendencias de diferenciación de xénero. Exemplo diso é AVA (Autodesk Virtual Agent), axente software que ofrece o servizo de atención ao cliente de produtos Autodesk en todo o mundo. Combina intelixencia artificial con intelixencia emocional paira falar “cara a cara” co cliente. Aínda que AVA foi creada por un equipo de traballo maioritariamente feminino, ten voz e aparencia feminina. A escusa é outra vez a mesma: as persoas sentimos as voces femininas máis amigables e colaborativas. Este exemplo pon de manifesto, por tanto, que non abonda con que as mulleres incorpórense aos grupos de traballo.

Una forma de eliminar as tendencias dos sistemas de aprendizaxe automática é mediante unha exhaustiva depuración e corrección das bases de datos utilizadas paira o adestramento. Hai investigadores que se dedican a iso e que eliminaron dos textos relaciones que non son lexítimas, por exemplo, homes/ordenadores e mulleres/electrodomésticos [6]. Outros investigadores, en cambio, propoñen crear clasificadores diferenciados paira clasificar cada un dos grupos representados nun conxunto de datos [7].

Está claro, por tanto, que todos temos que ter en conta que se os datos teñen una tendencia determinada, a tendencia será a mesma paira os sistemas que aprenden deles sen esforzo, o que pode ter consecuencias graves paira nós. Necesitaremos ferramentas paira detectar e identificar tendencias e principios paira a creación de novos conxuntos de datos. É posible que sexa necesario contar con expertos paira iso. E por que non desenvolver ferramentas de intelixencia artificial paira esa tarefa!