Il est temps que les machines prennent en compte la diversité humaine et l'inclusion

Les chercheurs font un grand effort pour que les machines puissent facilement identifier les êtres humains et maintenir une communication de plus en plus efficace avec eux. L'amélioration continue des interfaces a été dénoncée par des chercheurs de l'Université de Purdue (EEE). dans la revue Science pour ne pas tenir compte de la diversité humaine. Non seulement en ce qui concerne l'ethnie, mais aussi en ce qui concerne la classe sociale et les capacités. Ils disent que l'exclusion de la technologie continue d'être encouragée.

Pour concevoir les recherches, il faut tenir compte de la diversité humaine, sinon les interfaces reproduisent les mêmes préjugés et erreurs que les chercheurs. C'est pourquoi les groupes de recherche sur la relation entre machines et êtres humains ont souligné la nécessité d'avoir des scientifiques capables d'affronter l'hégémonie culturelle. Sinon, les machines ne seront pas intégrées dans notre environnement naturel, virtuel, psychologique, économique ou social.

Cependant, dans la plupart des cas, les chercheurs utilisent des citoyens txuris de haut niveau socio-économique dans le processus de développement d'interfaces et, par conséquent, ont constaté que de nombreux groupes d'entre eux sont en dehors de ces technologies.

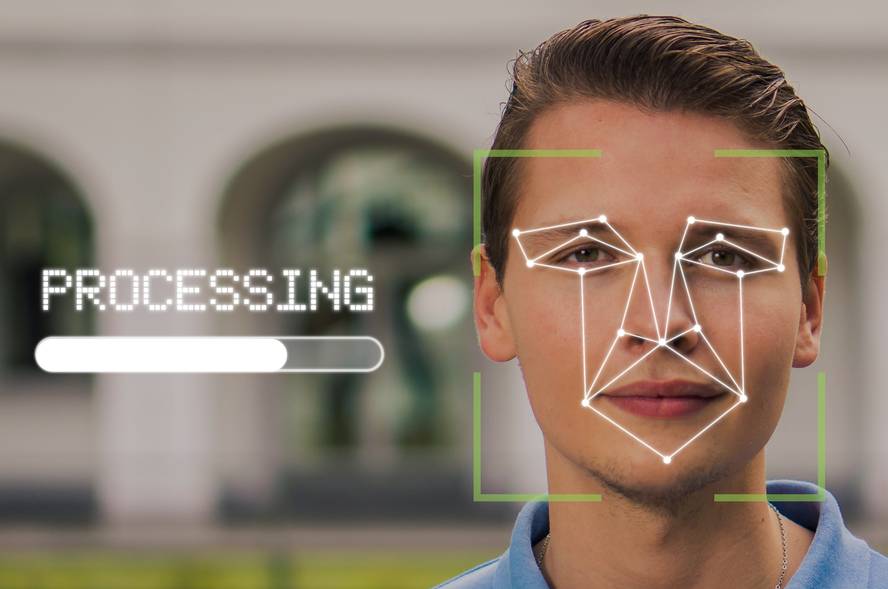

Par exemple, les interfaces font constamment des erreurs dans l'enregistrement et l'interprétation des données. Non seulement lorsque les gens interagissent activement avec les machines (par exemple, avec un véhicule autonome), mais aussi dans le cas d'utilisateurs conscients de l'interaction mais passifs (comme c'est le cas avec les dispositifs qui prennent des données pour le diagnostic médical), ou dans les cas où ils ne sont pas conscients et deviennent également des utilisateurs non autorisés de la technologie (technologies utilisées par la police pour l'analyse des visages).

Les conséquences sont graves : en s'entraînant les interfaces d'identification des maladies de la peau avec des personnes en peau blanche, de grandes erreurs se produisent dans les peaux sombres ; les algorithmes de reconnaissance faciale n'identifient pas bien des personnes racialisées ; et un long etc.

Les processus de formation des interfaces ont donc été sollicités pour les chercheurs qui intègrent enfin des citoyens de bas niveau socio-économique, des minorités ethniques, des migrants et des personnes à diversité fonctionnelle.