Es hora de que las máquinas tengan en cuenta la diversidad humana y la inclusión

Los investigadores están haciendo un gran esfuerzo para que las máquinas puedan identificar fácilmente a los seres humanos y mantener una comunicación cada vez más eficaz con ellos. La mejora continua de las interfaces ha sido denunciada por investigadores de la Universidad de Purdue (EE.UU.) en la revista Science por seguir sin tener en cuenta la diversidad humana. No sólo en lo que respecta a la etnia, sino también en lo que se refiere a la clase social y a las capacidades. Dicen que se sigue fomentando la exclusión de la tecnología.

A la hora de diseñar las investigaciones hay que tener en cuenta la diversidad humana, de lo contrario las interfaces reproducen los mismos prejuicios y errores que los investigadores. Por ello, los grupos de investigación sobre la relación entre máquinas y seres humanos han destacado la necesidad de contar con científicos capaces de afrontar la hegemonía cultural. De lo contrario, las máquinas no se integrarán en nuestro entorno natural, virtual, psicológico, económico o social.

Sin embargo, en la mayoría de los casos, los investigadores utilizan a ciudadanos y ciudadanas txuris de alto nivel socioeconómico en el proceso de desarrollo de interfaces y, por lo tanto, han comprobado que muchos grupos de ellas quedan fuera de estas tecnologías.

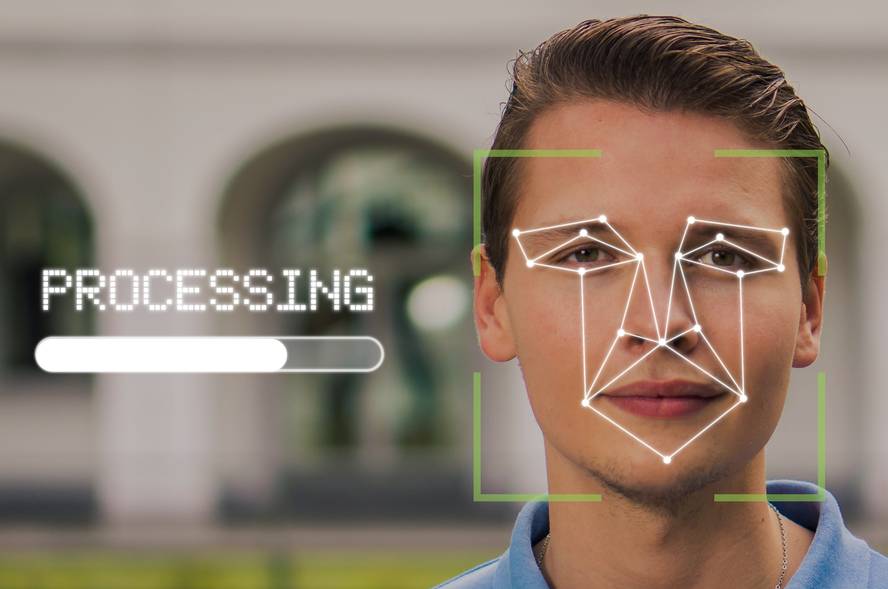

Por ejemplo, las interfaces constantemente cometen errores en el registro e interpretación de los datos. No sólo cuando las personas interaccionan activamente con las máquinas (por ejemplo, con un vehículo autónomo), sino también en el caso de usuarios conscientes de la interacción pero pasivos (como ocurre con los dispositivos que toman datos para el diagnóstico médico), o en aquellos casos en los que no son conscientes y además se convierten en usuarios no autorizados de la tecnología (tecnologías utilizadas por la policía para el análisis de caras).

Las consecuencias son graves: al entrenarse las interfaces de identificación de enfermedades cutáneas con personas de piel blanca, se producen grandes errores en las pieles oscuras; los algoritmos de reconocimiento facial no identifican bien a personas racializadas; y un largo etcétera.

Por tanto, en los procesos de entrenamiento de interfaces se ha solicitado a los investigadores que por fin integren a ciudadanos de bajo nivel socioeconómico, minorías étnicas, migrantes y personas con diversidad funcional.