Facteurs cachés dans la conception de produits

Dans l'évolution du marché de la consommation, les domaines qui influencent la production du produit ont pris une importance croissante.

Le produit n'est pas seulement conçu pour une utilisation concrète, mais il est aussi quelque chose qui répond aux besoins des clients. Par conséquent, un produit fonctionnellement meilleur qu'un autre semblable peut avoir moins de succès si votre approche marketing (politique de vente, publicité…) n'a pas été la bonne. Pour répondre aux besoins des clients, le produit doit atteindre au moins ces clients. Et c'est la raison de l'importance du marketing.

D'autre part, il faut garantir que le niveau de qualité du produit est conforme aux exigences du marché. Dans le cas contraire, les options d'acceptation du produit détermineront les niveaux de demande et les compétences du marché.

Les facteurs étroitement liés à la qualité du produit sont la fiabilité, la persévérance et la maintenabilité. Si le contrôle qualité a beaucoup à voir avec la production, les techniques de fiabilité servent également à assurer la qualité du produit au fil du temps. La persévérance du produit indique son état et suggère finalement des solutions en cas de panne. La maintenabilité, une fois que le produit a été mis à la disposition des clients, facilite la réparation de celui-ci en cas de panne.

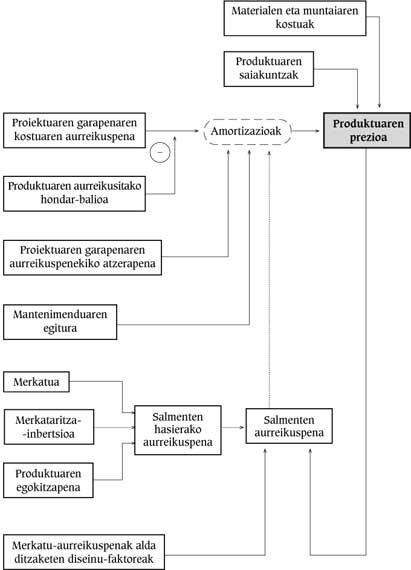

Le schéma suivant résume les relations entre les principaux facteurs intervenant dans la conception d'un produit et tout au long de sa vie.

Les facteurs qui influencent directement le prix du produit sont les coûts d'acquisition de matériaux, de montage et d'essais réalisés. En outre, le prix du produit doit tenir compte du coût de certains amortissements.

La fiabilité du système est la probabilité que certaines fonctions soient remplies dans un intervalle en fonction de conditions particulières. La meilleure façon d'obtenir la fiabilité est de développer un produit avec moins de pannes. Pour éviter cela, des modules redondants sont utilisés : si l'un d'eux échoue, les fonctions nécessaires seront remplies par ceux qui suivent correctement.

Les niveaux de fiabilité et de maintenabilité définis pour un système doivent être pris en compte dès les phases initiales de la conception, c'est-à-dire qu'un autre domaine est la conception.

Fonctionner sans se tromper pendant toute la vie est quelque chose qui se passe dans très peu de systèmes. Par conséquent, un fonctionnement incorrect doit être dans les prévisions.

En conséquence, en raison du risque de panne du système, un niveau de maintenance adéquat doit être organisé. Pour faciliter cela, il faut tenir compte dès les premières phases de la conception.

Facteurs de conception

Lors de la conception d'un produit, les principaux aspects à prendre en compte sont la réponse du marché et la difficulté de la conception.

Alors que la difficulté du design augmente linéairement, le temps de conception et d'investissement augmentent de façon exponentielle. Pour le justifier, les prévisions de marché devraient être bonnes.

De même, l'organisation et la gestion du design sont les facteurs les plus importants pour la bonne marche. L'influence des concepteurs du projet sur le développement correct du projet dépend de nombreuses variables. L'un d'eux est le niveau de performance global du projet. Les causes d'un mauvais rendement du travail peuvent être très différentes. La concordance de ces causes réduit de façon exponentielle le rendement. Il est très difficile que la performance dépasse 80%.

L'image ci-dessus montre l'émulateur utilisé pour aider la conception.

Fiabilité et fiabilité

La fiabilité du système est le résultat de la fiabilité du matériel et du logiciel.

Lorsque les projets sont petits ou moyens, des calculs ou des tests de fiabilité ne sont généralement pas effectués. En fait, dans ces cas, il y a peu d'argent pour développer le produit et souvent leur fiabilité et leur besoin sont inconnus.

Le plus grand risque de retards dans le développement de la fiabilité se produit quand il n'a pas été pris en compte depuis le début du projet; le besoin de fiabilité est pris en compte dans les phases finales du projet après l'approbation des prototypes.

L'indicateur de fiabilité du système est MTBF ( Mean Time Between Failures ), c'est-à-dire le temps moyen entre les pannes, ou la même chose, la relation entre le temps total de fonctionnement et le nombre de pannes.

La fiabilité est généralement calculée par la norme MIL-HDBK-217, en utilisant la MTBF du système. Les résultats obtenus sont très conservateurs.

Le degré de fiabilité d'un produit dans certains cas coïncide avec la spécification du projet. Dans la plupart des cas, cependant, la fiabilité est une exigence indéterminée et contraignante du produit.

Le risque potentiel par manque de fiabilité détermine les minima de FVTM exigés par le marché.

Essais de fiabilité

Des essais spéciaux doivent être préparés pour mesurer la fiabilité réelle du design.

La probabilité de défaillance au début de la vie des composants électroniques est très élevée et est donc connue comme une défaillance prématurée. Pour éviter cela, avant l'essai fonctionnel, le composant doit subir un processus de chauffage (combustion). Cela permet d'atténuer les réactions chimiques à l'intérieur des semi-conducteurs, étant le fonctionnement d'une semaine à haute température équivalente à celle qui se produirait pendant quelques mois à des températures inférieures.

La quantification du réchauffement peut être approchée par l'équation d'Ahrrenius.

Q = vitesse de réaction chimique

A = constante

Ea = énergie d'activation (eV) de la réaction chimique

K = constante de Boltzman (8.61.10-5eV/ºK), et

T = température de réaction absolue (ºK).

Par exemple, par cette voie, si un composant fonctionnant à 40ºC est soumis à un réchauffement atteignant une température de 125 ºC, et en supposant une période de 20 semaines de défaillance précoce, il suffirait d'une demi-heure de réchauffement.

Toutefois, la température ambiante maximale autorisée sera déterminée par les composants fabriqués à partir de condensateurs et de plastiques, dans ce cas de 60 à 90 °C.

La marge pour surmonter le manque précoce (dans le cas de la combustion) est de 48-168 heures, car elle dépend des ingrédients, la valeur la plus appropriée sera toujours celle qui apporte l'expérience.

Le grand avantage de l'essai d'erreur de fiabilité, en plus d'obtenir des données de fonctionnement, est de connaître les pannes du système à long terme. Ces erreurs apparaissent tout au long de l'essai de fiabilité, ce qui permet de corriger la conception.

Lorsque les résultats obtenus dans le calcul du FTC ou par l'essai de fiabilité sont pires que prévu, une amélioration de la fiabilité du système devrait être développée.

Ceci, en plus de nécessiter des composants spéciaux ou des techniques redondantes, peut impliquer une refonte de l'ensemble du design, qui peut bien sûr représenter le coût de la conception.

Un autre essai pour assurer la fiabilité est le tremblement. Par cette session, en dehors des types de défaillances que l'on peut rencontrer dans le réchauffement, d'autres types de défaillances peuvent apparaître, principalement des mauvaises soudures et des défaillances périodiques.

Systèmes redondants

Dans le cas de nombreux équipements, l'effet de certaines cavités est totalement inacceptable. Si, compte tenu des composants du système, le niveau de fiabilité nécessaire n'est pas atteint, des modules supportant des erreurs doivent être conçus à l'aide de techniques redondantes.

Face à une erreur, trois types d'actions peuvent être effectués :

- Que le système ne perde pas ses caractéristiques: si un système informatique sans redondance a une disponibilité moyenne de 0.99, un redondant peut avoir un utilitaire de 0.999999.

- Le système, bien qu'il puisse continuer à fonctionner, perd certaines fonctionnalités (graceful dégradation).

- Le système ne peut plus fonctionner, mais reste en sécurité (safe shutdown).

Fiabilité du logiciel

Les perspectives de fiabilité du matériel et du logiciel sont assez différentes. Dans les systèmes matériels vides, le comportement peu fiable est dû à des pannes de composants et non à des pannes de conception. Les lacunes du logiciel sont des erreurs directes du concepteur et sont données dans des situations très concrètes.

La voie la plus recommandée pour obtenir la fiabilité du logiciel est de le coder sans vide, car si vous appliquez des techniques de tolérance, les coûts seraient plus élevés. Les raisons de ce type de techniques doivent être très évidentes.

Bien que ces techniques soient plus complexes que celles non tolérées, leur gestion n'en est pas ainsi, c'est-à-dire que le niveau auquel elles doivent être atteintes sera parfaitement défini dans les conditions que doivent remplir les produits.

Une fois le codage et le débogage effectués, le niveau de qualité du logiciel sera mesuré en tenant compte du produit et des exigences du marché.

Les méthodes pour mesurer la fiabilité du logiciel ne sont pas faciles à utiliser. L'une des principales barrières est due à l'incertitude entre le développement et l'acquisition de données.

La méthode la plus utilisée est celle qui a commencé à se développer en 1973. Cette méthode permet de visualiser le nombre de postes vacants par phase de développement.

La méthode SAAM est basée sur une augmentation exponentielle du nombre d'heures d'essais MTBF du logiciel.

Entretien et entretien Entretien

La maintenance comprend l'entretien et la réparation. Le programme de maintenance oblige à réaliser des investissements rentables importants à différents moments de la vie du système, tels que le prédesign, la conception et la fabrication.

Le facteur qui influence significativement l'intervalle de réparation d'un système défectueux est le service de réparation et la distance entre les clients.

Plus la durabilité de l'équipement est élevée, plus il est facile de trouver le module détruit. Sinon, pour savoir quel est le composant qui est mal, les outils et les connaissances spécifiques seront obligatoires.

En général, trois politiques de maintenance peuvent exister :

- Maintenance post-défaillance : aucun entretien n'est effectué tant que la défaillance n'a pas lieu.

- Entretien prévu : certaines réparations et modifications sont effectuées à des intervalles déterminés en fonction de la date et de l'âge du composant.

- Entretien conditionné: grâce à plusieurs contrôles du système, vous obtenez une connaissance approfondie de celui-ci et le composant à modifier est connu avant qu'il ne faille.

Disponibilité :

La variable indiquant dans quelle proportion de la plage que le système doit fonctionner correctement est la DISPONIBILITÉ.

MTTR, indicateur du degré d'entretien du système, est le temps moyen de réparation ( Mean Time To Repair ), c'est-à-dire le rapport entre le temps total employé dans la réparation de tous les défauts d'une période et le nombre de défaillances.

Ainsi, si le système était facilement réparable (avec un MTTR réduit), la disponibilité serait élevée, même si la fiabilité (MTBF) n'était pas très bonne.

La variable RAM (Reliability, Availability, Maintainability, fiabilité, disponibilité, maintenabilité) est un indicateur d'utilité.

Persévérance

Il est souhaitable que la détection du bogue soit claire et visible pour faciliter son entretien. Ces méthodes ont été considérablement améliorées dans les systèmes électroniques, notamment avec des microprocesseurs.

Les systèmes d'essai peuvent être classés aux niveaux suivants:

- ESSAI MAIN : l'essai est effectué par une personne utilisant des outils manuels. Cela, bien que lent, est généralement assez fiable.

- ESSAI SEMI-AUTOMATIQUE: quand le travail de la personne est entre 2% et 50% du temps total. Ceci est intéressant pour les essais de systèmes similaires.

- ESSAI AUTOMATIQUE: un équipement est utilisé pour réduire les tâches de maintenance des opérateurs. En général, après une analyse approfondie et la détection d'une erreur, il est communiqué à l'opérateur pour étudier les données et prendre des décisions. Le temps de travail n'atteint pas 2% du temps total d'essai.

- ESSAI INTÉGRÉ DANS LE SYSTÈME LUI-MÊME: les composants de l'essai sont intégrés dans le système lui-même ou des signaux de diagnostic peuvent être extraits pour être analysés par un autre système externe.

L'équipement le plus utilisé pour l'essai de cartes électroniques est l'essai fonctionnel. Une telle équipe peut trouver 95% des pannes. En plus de son coût élevé, le temps de programmation d'un technicien expert est également élevé en raison de la complexité du logiciel qu'il utilise.

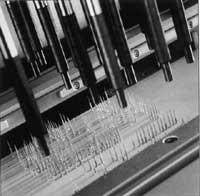

Pour réaliser l'essai sur le circuit, les équipements réalisent des essais des paramètres de chacun des composants à travers le lit de captage formé par les points d'essai. Sa programmation est généralement simple et avec une efficacité moyenne de détection des pannes de 80%.

L'utilisation la plus intéressante des équipements du circuit est la combinaison avec ceux qui réalisent l'essai fonctionnel, c'est-à-dire l'élimination d'une partie de la charge de l'équipement d'essai fonctionnel, en fixant les composants avec des paramètres hors de certaines limites.

La seule bonne façon pour l'approbation des produits par essai de prototype est de vérifier le fonctionnement du pire cas. C'est à dire, l'état d'environnement d'essai (chaleur, humidité, vibration, etc.) et le niveau de fonctionnement des composants électroniques doivent être en mesure de répondre à toute situation acceptable dans les spécifications.