Factores ocultos en el diseño de productos

En el avance del mercado de consumo, las áreas que inciden en la generación del producto han ido adquiriendo cada vez mayor relevancia.

El producto no es sólo algo diseñado para un uso concreto, sino que también es algo que satisfaga las necesidades de los clientes. Por ello, un producto funcionalmente mejor que otro similar puede tener un menor éxito si su planteamiento de comercialización (política de ventas, publicidad…) no ha sido el adecuado. Para poder cubrir las necesidades de los clientes, el producto debe llegar al menos a estos clientes. Y esa es la razón de la importancia del marketing.

Por otro lado, se debe garantizar que el nivel de calidad del producto se ajusta a las exigencias del mercado. En caso contrario, las opciones de aceptación del producto determinarán los niveles de demanda y las competencias del mercado.

Los factores estrechamente relacionados con la calidad del producto son la fiabilidad, la perseverancia y la mantenibilidad. Si el control de calidad tiene mucho que ver con la producción, las técnicas de fiabilidad también sirven para asegurar la calidad del producto a lo largo del tiempo. La perseverancia del producto indica el estado del mismo y finalmente sugiere soluciones en caso de avería. La mantenibilidad, una vez que el producto ha sido puesto a disposición de los clientes, facilita la reparación del mismo en caso de avería.

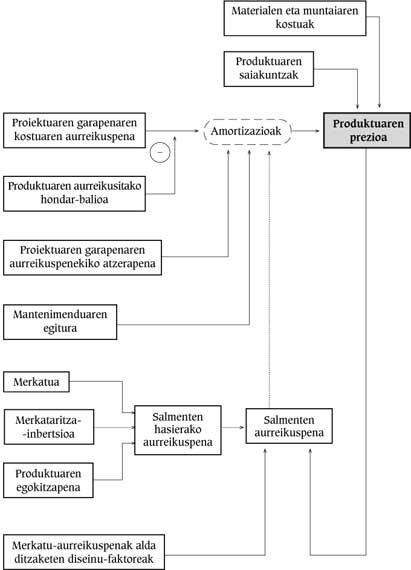

El esquema siguiente resume las relaciones entre los principales factores que intervienen en el diseño de un producto y a lo largo de su vida.

Los factores que inciden directamente en el precio del producto son los costes de adquisición de materiales, montaje y ensayos realizados. Además, en el precio del producto hay que tener en cuenta el coste de algunas amortizaciones.

La fiabilidad del sistema es la probabilidad de que en un intervalo se cumplan determinadas funciones en función de unas condiciones concretas. La mejor forma de conseguir la fiabilidad es desarrollar un producto con menos fallos. Para evitarlo, se utilizan módulos redundantes: si uno de ellos falla, las funciones necesarias las cumplirían quienes siguen correctamente.

Los niveles de fiabilidad y mantenibilidad definidos para un sistema deben tenerse en cuenta desde las fases iniciales del diseño, es decir, se asume que un área más es el diseño.

Funcionar sin equivocarse durante toda la vida es algo que ocurre en muy pocos sistemas. Por tanto, un funcionamiento incorrecto debe estar dentro de las previsiones.

Como consecuencia de todo ello, debido al riesgo de avería del sistema, se debe organizar un nivel de mantenimiento adecuado. Para facilitarlo, se debe tener en cuenta desde las primeras fases del diseño.

Factores de diseño

A la hora de diseñar un producto, los principales aspectos a tener en cuenta son la respuesta del mercado y la dificultad del diseño.

Mientras la dificultad del diseño aumenta linealmente, el tiempo de diseño y la inversión aumentan exponencialmente. Para justificarlo, las previsiones de mercado deberían ser buenas.

Asimismo, la organización y gestión del diseño son los factores más importantes para la buena marcha. La influencia de los diseñadores del proyecto en el correcto desarrollo del proyecto depende de muchas variables. Uno de ellos es el nivel de rendimiento global del proyecto. Las causas de un mal rendimiento laboral pueden ser muy diferentes. La concurrencia de estas causas reduce exponencialmente el rendimiento. Es muy difícil que el rendimiento supere el 80%.

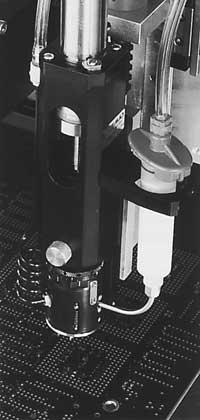

En la imagen superior se muestra el emulador utilizado para ayudar al diseño.

Fiabilidad

La fiabilidad del sistema es el resultado de la fiabilidad del hardware y software.

Cuando los proyectos son pequeños o medianos, en general no se realizan cálculos o pruebas de fiabilidad. De hecho, en estos casos hay poco dinero para desarrollar el producto y muchas veces se desconoce su fiabilidad y necesidad.

El mayor riesgo de retrasos en el desarrollo de la fiabilidad se produce cuando no se ha tenido en cuenta desde el inicio del proyecto; la necesidad de fiabilidad se tiene en cuenta en las fases finales del proyecto tras la aprobación de los prototipos.

El indicador de fiabilidad del sistema es MTBF ( Mean Time Between Failures ), es decir, el tiempo medio entre fallos, o lo que es lo mismo, la relación entre el tiempo total de funcionamiento y el número de fallos.

La fiabilidad, en general, se calcula a través de la normativa MIL-HDBK-217, recurriendo a la MTBF del sistema. Los resultados obtenidos son muy conservadores.

El grado de fiabilidad de un producto en algunos casos coincide con la especificación del proyecto. En la mayoría de los casos, sin embargo, la fiabilidad es un requisito indeterminado y de obligado cumplimiento del producto.

El riesgo potencial por falta de fiabilidad determina los mínimos de FVTM exigidos por el mercado.

Ensayos de fiabilidad

Para medir la fiabilidad real del diseño se deben preparar ensayos especiales.

La probabilidad de fallo al inicio de la vida de los componentes electrónicos es muy elevada por lo que se conoce como fallo prematuro. Para evitarlo, antes de realizar el ensayo funcional, el componente debe someterse a un proceso de calentamiento (combustión). Esto permite mitigar las reacciones químicas en el interior de los semiconductores, siendo el funcionamiento de una semana a alta temperatura equivalente al que se produciría durante unos meses a temperaturas inferiores.

La cuantificación del calentamiento puede aproximarse mediante la ecuación de Ahrrenius.

Q = velocidad de reacción química

A = constante

Ea = energía de activación (eV) de la reacción química

K = constante de Boltzman (8.61.10-5eV/ºK), y

T = temperatura absoluta de reacción (ºK).

Por ejemplo, mediante esta vía, si a un componente que funciona a 40ºC se le somete a un calentamiento que alcanza una temperatura de 125 ºC, y suponiendo un periodo de 20 semanas de fallo temprano, bastaría con una media hora de calentamiento.

No obstante, la temperatura ambiente máxima permitida vendrá determinada por los componentes fabricados con condensadores y plásticos, en este caso de 60-90 ºC.

El margen para superar la falta temprana (en el caso de la combustión) es de 48-168 horas, ya que depende de los ingredientes, el valor más adecuado será siempre el que aporte la experiencia.

La gran ventaja del ensayo de error de fiabilidad, además de obtener unos datos de funcionamiento, es conocer los fallos del sistema a largo plazo. Estos errores van apareciendo a lo largo del ensayo de fiabilidad, lo que permite corregir el diseño.

Cuando los resultados obtenidos en el cálculo del FTC o mediante el ensayo de fiabilidad son peores de lo debido, se debería desarrollar una mejora de la fiabilidad del sistema.

Esto, además de requerir componentes especiales o técnicas redundantes, puede suponer un replanteamiento de todo el diseño, que por supuesto puede encarecer el coste del diseño.

Otro ensayo para asegurar la fiabilidad es el temblor. Mediante esta sesión, al margen de los tipos de fallos que se pueden encontrar en el calentamiento, pueden aparecer otros tipos de fallo, principalmente malas soldaduras y fallos periódicos.

Sistemas redundantes

En el caso de muchos equipos, el efecto de algunas husuzas es totalmente inaceptable. Para ello, si teniendo en cuenta los componentes del sistema, no se puede alcanzar el nivel de fiabilidad necesario, se deben diseñar módulos que soporten errores mediante técnicas redundantes.

Ante un error, se pueden llevar a cabo tres tipos de acciones:

- Que el sistema no pierda sus características: si un sistema de computadores sin redundancia tiene una disponibilidad media de 0.99, una redundante puede tener una utilidad de 0.999999.

- El sistema, aunque puede seguir funcionando, pierde alguna característica (la graceful degradation).

- El sistema no puede seguir funcionando, pero se queda en un estado seguro ( safe shutdown ).

Fiabilidad del software

Las perspectivas de fiabilidad del hardware y software son bastante diferentes. En los sistemas de hardware vacío, el comportamiento poco fiable se debe a fallos en los componentes y no a fallos de diseño. Las deficiencias del software son errores directos del diseñador y se dan en situaciones muy concretas.

La vía más recomendable para conseguir la fiabilidad del software es codificarlo sin vacío, ya que en caso de aplicar técnicas de tolerancia los costes serían mayores. Las razones de este tipo de técnicas deben ser muy evidentes.

Si bien estas técnicas son más complejas que las no toleradas, su gestión no es así, es decir, el nivel al que se debe llegar estará perfectamente definido en las condiciones que deben cumplir los productos.

Una vez realizada la codificación y depuración del software se medirá el nivel de calidad del mismo teniendo en cuenta el producto y los requerimientos del mercado.

Los métodos para medir la fiabilidad del software no son fáciles de usar. Una de las mayores barreras se debe a la incertidumbre existente entre el desarrollo y la adquisición de datos.

El método más utilizado es el que comenzó a desarrollarse en 1973. Este método permite visualizar el número de vacantes por fase de desarrollo.

El método de SAAM se basa en un aumento exponencial del número de horas de ensayos MTBF del software.

Mantenimiento

La mantenibilidad incluye el mantenimiento y la reparación. El programa de mantenimiento obliga a realizar importantes inversiones rentables en diferentes momentos de la vida del sistema, como son el prediseño, el diseño y la fabricación.

El factor que influye significativamente en el intervalo de reparación de un sistema averiado es el servicio de reparación y la distancia entre clientes.

Cuanto mayor sea la durabilidad del equipo, más fácil será encontrar el módulo destruido. Si no, para saber cuál es el componente que está mal, las herramientas y conocimientos específicos serán obligatorios.

En general pueden existir tres políticas de mantenimiento:

- Mantenimiento post-fallo: no se realiza ningún mantenimiento hasta que se produzca el fallo.

- Mantenimiento previsto: se realizan determinadas reparaciones y modificaciones en intervalos determinados en función de la fecha y edad del componente.

- Mantenimiento condicionado: a través de múltiples controles del sistema se obtiene un profundo conocimiento del mismo y se conoce el componente a modificar antes de que falla.

Disponibilidad

La variable que indica en qué proporción del rango que debe funcionar el sistema está funcionando correctamente es la DISPONIBILIDAD.

MTTR, indicador del grado de mantenimiento del sistema, es el tiempo medio de reparación ( Mean Time To Repair ), es decir, la relación entre el tiempo total empleado en la reparación de todos los fallos de un periodo y el número de fallos.

De esta forma, si el sistema fuera fácilmente reparable (con un MTTR reducido) la disponibilidad sería alta, aunque la fiabilidad (MTBF) no fuera muy buena.

La variable RAM (Reliability, Availability, Maintainability, fiabilidad, disponibilidad, mantenibilidad) es un indicador de utilidad.

Perseverancia

Es conveniente que la detección del fallo sea clara y visible para facilitar su mantenimiento. En los sistemas electrónicos se han mejorado notablemente estos métodos, sobre todo con microprocesadores.

Los sistemas de ensayo se pueden clasificar en los siguientes niveles:

- ENSAYO DE MANO: el ensayo lo realiza una persona utilizando herramientas manuales. Esto, aunque lento, suele ser bastante fiable.

- ENSAYO SEMIAUTOMÁTICO: cuando el trabajo de la persona está entre el 2% y el 50% del tiempo total. Esto es de interés para ensayos de sistemas similares.

- ENSAYO AUTOMÁTICO: se utiliza un equipo para reducir las tareas de mantenimiento de los operarios. En general, tras un análisis exhaustivo y la detección de un error, lo comunica al operario para que estudie los datos y tome decisiones. El tiempo de trabajo no llega al 2% del tiempo total de ensayo.

- ENSAYO INTEGRADO EN EL PROPIO SISTEMA: los componentes del ensayo están integrados en el propio sistema o se pueden extraer señales de diagnóstico para ser analizados por otro sistema externo.

El equipo más utilizado para el ensayo de tarjetas electrónicas es el ensayo funcional. Un equipo de este tipo puede encontrar el 95% de los fallos. Además de su elevado coste, el tiempo de programación de un técnico experto es también elevado debido a la complejidad del software que utiliza.

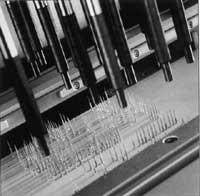

Para realizar el ensayo en el circuito, los equipos realizan ensayos de los parámetros de cada uno de los componentes a través de la cama de captación formada por los puntos de ensayo. Su programación suele ser sencilla y con una eficiencia media de detección de fallos del 80%.

El uso más interesante de los equipos del circuito es la combinación con los que realizan el ensayo funcional, es decir, la eliminación de parte de la carga del equipo de ensayo funcional, fijando los componentes con parámetros fuera de ciertos límites.

La única forma buena para la aprobación de productos mediante ensayo de prototipos es comprobar el funcionamiento del peor caso. Es decir, el estado de ambiente de ensayo (calor, humedad, vibración, etc.) y el nivel de funcionamiento de los componentes electrónicos deben ser capaces de responder a cualquier situación aceptable en las especificaciones.