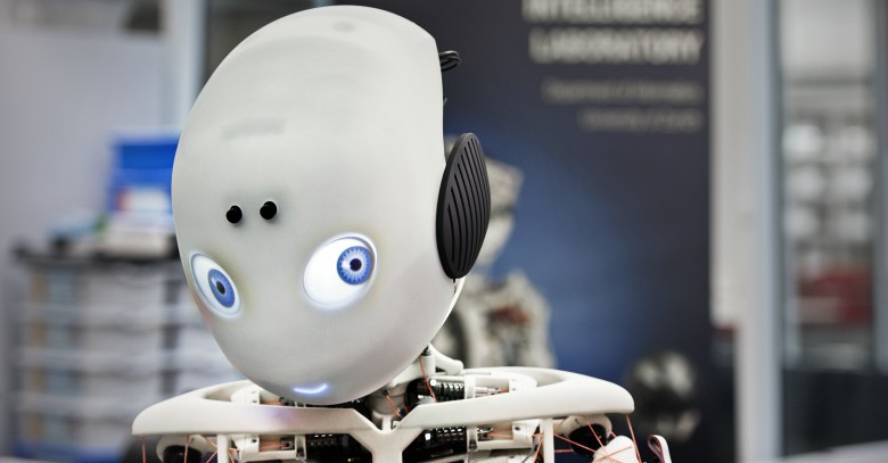

Cap a una societat humana i robòtica

Fa 65 anys, l'escriptor Isaac Asimov va presentar en el conte Runaround tres lleis per a la robòtica: 1) El robot no perjudicarà l'ésser humà i evitarà que l'home sigui danyat; 2) el robot complirà les ordres donades per l'home, tret que s'oposi a la primera llei; i 3) el robot s'autoprotegirà si no va en contra de la primera i segona llei.

Asimov va plasmar en la convivència a persones i robots en els seus relats de ciència-ficció, i per a aquesta convivència va veure necessari programar els robots d'acord amb aquestes lleis. Però aquest món ja no és tan fictici: els vehicles autònoms, els drons, els robots per a ajudar als majors i als discapacitats, tots els que entren en la indústria i les màquines capaces d'aprendre.

“És innegable que s'està produint una revolució”, explica Elena Lazkano Ortega, investigadora del departament de Ciència de la Computació i Intel·ligència Artificial de la UPV. No obstant això, no té tan clar la velocitat que aconseguirà aquesta revolució: “A vegades em sembla que és aquí, que ens ve damunt, i altres vegades els avanços són enormement lents”. Gorka Azkune Galparsoro, investigador en intel·ligència artificial en Deustotech-Deusto: “Des del punt de vista de la intel·ligència artificial ha ocorregut un gran salt que no s'ha vist durant molts anys. És molt difícil predir fins a quin punt les coses canviaran, però jo crec que d'aquí a no massa anys, tindrà una gran influència en la nostra vida”.

Davant aquesta situació es necessitarà alguna cosa més que les lleis d'Asimov, i països com els EUA, la Xina, el Japó o la Unió Europea ja han començat a tractar el tema. Azkune considera que en alguns casos ja són necessàries les legislacions. “Per exemple, als EUA hi ha diversos Estats que estan desenvolupant legislacions sobre vehicles autònoms. Aquesta tecnologia ja és molt madura”. Però també veu el perill d'avançar massa en les legislacions: “Em fa por limitar els possibles desenvolupaments legislatius. Cal anar preparant-se, això és clar, però no sé fins a quin punt es pot avançar”. Doncs bé, per a fer les coses bé, Lazkano veu necessari un debat profund: “És un debat en el qual tots hem de participar, indústria, universitats i fins i tot societat. No podem deixar en mans dels governs sol fer una legislació”.

El mes de febrer passat el Parlament Europeu va sol·licitar a la Comissió Europea que proposés lleis per a la robòtica i la intel·ligència artificial. Aquesta petició es basava en l'estudi de les lleis civils de la robòtica extretes per la Comissió d'Assumptes Europeus de Dret. A Gran Bretanya, l'Organització Britànica BSI Estàndard també va llançar l'any passat les normes per al disseny ètic dels robots. Com una actualització de les lleis d'Asimov, també han destacat tres punts generals: 1) Els robots no han de dissenyar-se sol o principalment per a matar als éssers humans; 2) Els responsables de les accions dels robots són humans, no robots; i 3) Ha de ser possible saber qui és el responsable de cada robot i de les seves accions.

A més de la seguretat de les persones, han posat el focus en les preocupacions. Lazkano coincideix en això: “Els robots els dissenyem nosaltres i de moment les accions dels robots. I en la mesura en què això sigui així, som responsables. Per exemple, els vehicles autònoms necessiten de moment un supervisor. El comprador del cotxe el comprarà amb unes condicions i, en cas d'accident, si ha respectat aquestes condicions, el responsable serà el dissenyador, i si no ha respectat les condicions, l'usuari. No podem atribuir-li l'error. Això seria justificar-nos”.

Capacitat d'aprenentatge

Però, segons Azkun, pot ser que no sempre estigui tan net. “Sovint es pensa que els robots es programen per a fer una cosa. Però avui dia els robots són capaços d'aprendre i probablement més en el futur. I la capacitat d'aprenentatge pot generar autonomia de decisió. Llavors, a mesura que aquests robots van aprenent pel seu compte, qui és el responsable del que aprenen? En definitiva, si aprenen de nosaltres, nosaltres serem responsables, però aquesta responsabilitat pot quedar molt diluïda en la societat”.

Compara el que ocorre amb les persones: “Un nen al principi no sap res. Si després es converteix en un assassí, a qui correspon? Segur que la societat ha comès alguns errors, o els altres... En aquest cas es culpa a aquesta persona. Llavors caldrà veure-ho... Des d'un punt de vista determinista o programàtic pot ser més fàcil, però la intel·ligència artificial és gratuïta, i amb la força que està adquirint l'aprenentatge, aquestes coses probablement no es poden resoldre tan fàcilment”.

No obstant això, la capacitat d'aprenentatge de la intel·ligència artificial continua sent limitada. “De moment ingereixen dades, aprenen el que hi ha en ells i només tenen una certa capacitat de generalització”, explica Lazkano. “Així, si les dades que se'ls facilitin són ètics, les sortides també seran ètiques”. Però, per descomptat, tampoc sempre serà fàcil que les dades que se'ls facilitin siguin ètics, per exemple, en utilitzar dades d'Internet. Prova d'això és el que va ocórrer amb el xat Tay de Microsoft: Es van posar en Twitter i van haver de retirar els comentaris racistes, sexistes, nazis, etc. en 24 hores. Per descomptat, va aprendre de les entrevistes en twitter.

“A això se'n diu el problema del món obert”, afirma Azkun. “Si obrim el món a les intel·ligències artificials i deixem que es prenguin totes les dades podrien sorgir problemes. Això es pot controlar, però fins quan volem que aquestes intel·ligències siguin cada vegada més potents?”. A mesura que augmenta la capacitat d'aprendre, les coses podrien canviar. “El Deep Mind de Google ja parla d'intel·ligència general artificial”, afirma Azkune. Una intel·ligència general artificial seria capaç de prendre decisions per si mateixa. “Avui dia, la intel·ligència artificial està bastant controlada en funció de les dades i de la tècnica d'aprenentatge que utilitzis, però a mesura que anem avançant i tinguin més llibertat per a decidir aquestes intel·ligències, no serà tan fàcil controlar el que poden aprendre”.

Però Azkun aclareix que això està lluny d'ocórrer: “En els últims anys s'han produït grans avanços, i si els projectem al futur podria aparèixer un món bastant diferent, però encara no estem tan avançats en aquest sentit. Encara estem a nivell d'especialització: tenim petites intel·ligències que són molt bones fent coses concretes, però aquesta generalitat que té l'ésser humà no es veu pròxima. És cert que precisament enguany s'han realitzat petits avanços en intel·ligència general. Però encara estem en una recerca molt bàsica, que pot arribar, però no sabem”.

Mans humanes

Lazkano té clar que els robots són ètics en mans dels éssers humans. “Si nosaltres no els ensenyem comportaments ètics, els robots que fabriquem no tindran un comportament ètic”. I no hem d'oblidar què són. “Sens dubte hem de pensar en quin ús volem donar-li. Però són només eines. Eines per a fer mil coses, també per a parlar, però són eines”.

També Azkun ha destacat aquesta perspectiva. “Hem de tenir en compte que, com qualsevol tecnologia, pot tenir contres, i cal intentar prevenir-les, però no tenir por. Aquesta tecnologia encara està per desenvolupar, perquè pensem com l'hem utilitzat per a solucionar problemes reals. Per exemple, la intel·ligència artificial ja s'ha utilitzat per a detectar el càncer de pell i el fa millor que l'home. Podrien existir altres mil casos. La teràpia contra el càncer o el nou medicament pot generar intel·ligència artificial o predir el seu efecte. Hauríem de pensar en aquestes coses. Com podem utilitzar aquests nous poders per a fer front als problemes que tenim. Però, clar, sempre cal pensar que això no s'ha de convertir en un problema".

Per exemple, s'està discutint si crear vincles emocionals amb els robots pot convertir-se en un problema, per exemple. Lazkano considera que això és inevitable: “El fetitxisme és propi. Tendim a crear vincles emocionals amb els objectes i amb els robots igual”. I sovint pot ser per a bé: “Diverses recerques han demostrat que els llaços emocionals que tenen els nens autistes, les persones majors i uns altres amb els robots són beneficiosos per a ells. Per exemple, els majors que viuen solos aprecien molt tenir un robot a casa i, encara que avui dia són molt limitats, s'ha vist que es crea un vincle emocional amb aquests robots, que és bo per a ells. Se senten més segurs a casa, estan millor emocionalment, etc. En altres casos pot ser un problema, però també té beneficis”.

I un altre dels problemes que preocupa, i que pot estar més a prop, és el de l'eliminació de llocs de treball per part dels robots. “Hi ha llocs de treball que es perdran, però pot ser que aquests treballadors puguin fer altres treballs i que els robots generin noves professions”, preveu Lazkano. “No sé fins a quin punt serà violent. Aquesta por ens ha ficat en altres revolucions industrials”.

Azkune coincideix: “Això ha ocorregut moltes vegades en la nostra història i jo crec que a poc a poc trobarem el nostre lloc. Sempre hi haurà una fase de transició en la qual la gent passi malament. Però no pensem que aquesta gent, com sempre es diu, sigui la gent menys formada. Jo no descarto en absolut que la intel·ligència artificial sigui capaç de crear teories, de plantejar proves i experiments, etc., i en aquest cas llevar-li molta feina als científics. No sabem en quin sentit vindran els canvis i a tots ens toca adaptar-se a ells”.

“I si arriba una societat en la qual tot està automatitzat i l'home no ha de treballar, no em sembla una cosa negativa”, ha afegit Azkune. “Haurem d'evolucionar a una altra mena de societat”.

Una societat de persones i robots

Aquesta possible societat seria una societat de persones i robots. Lazkano considera que dins d'uns deu anys els robots poden ser a les cases, però d'aquí al fet que els robots siguin part de la societat hi ha una sagnia. “Potser ve. Una de les claus més importants seria aconseguir la nostra capacitat de diàleg. I hi ha màquines capaces de mantenir una conversa coherent durant un parell de minuts, però de seguida t'adones que estàs treballant amb una màquina. Fins a aconseguir-ho tindràs una màquina a casa, no un amic o el que sigui”.

Caldrà veure a quin nivell arriben els robots o les intel·ligències artificials. “Jo tinc clar que si arriben al nivell dels éssers humans, o el superen, hauran de ser tractats com a iguals quant a responsabilitats legals i ètiques. Si un robot comet un assassinat, haurà de jutjar-se com una persona o amb mecanismes similars. Si reconeixem que tenen llibertat de decisió i capacitat d'aprenentatge, etc., haurem de considerar-los iguals en aquest sentit. La clau és el nivell d'intel·ligència que s'aconsegueix. Hauran de ser tractats en conseqüència. En l'actualitat, els animals no tenen el mateix tractament que els humans, ni un nen ni un adult. Sorgiran moltes preguntes i caldrà treballar molt, si ocorre”.