Portail de Corpus Web : Grand magasin de textes en basque réalisés par Elhuyar R & D

Pour une langue, il est très important de disposer de corpus textuels (collections de textes servant à réaliser des études linguistiques). Elles sont indispensables pour l'obtention de données pour la réalisation d'études linguistiques ou pour la prise de décision dans la standardisation linguistique. Et ils sont très utiles aussi dans la création de textes ou dans la traduction : ils peuvent nous expliquer comment des mots qui n'apparaissent pas dans les dictionnaires ou qui n'ont pas d'exemples suffisants ont été utilisés ou traduits.

Mais en outre, les corpus sont d'une importance vitale dans le monde des technologies linguistiques. Dans les systèmes de reconnaissance vocale apportés par les téléphones mobiles intelligents d'aujourd'hui, par exemple, on utilise corpus pour essayer d'inventer un mot qui n'a pas été compris du tout bien, en regardant dans les corpus ce qui est le plus probable dans ce contexte, ou les systèmes de traduction automatique, par exemple, utilisent corpus parallèles (corpus formés par des textes qui sont des traductions réciproques) pour apprendre, comme on vous le raconte dans le numéro de novembre 2009.

Combien plus grands corpus mieux

Dans ce même article, nous avons souligné que plus ces corpus sont grands. Pour consulter l'utilisation d'un mot rare il y aura plus d'apparitions différentes ou plus de chances d'apparaître si le corpus est plus grand. Traduction automatique nécessite aussi corpus de taille aussi grande que possible, d'où Google est référence dans la traduction automatique multilingue, car avec les textes indexés pour le moteur de recherche sont formés corpus parallèles énormes.

Comme dans beaucoup d'autres domaines, l'euskera est bien derrière d'autres langues avec plus de ressources, tant en taille qu'en temps. Passons en revue la situation de l'anglais : le corpus anglais Brown, qui est considéré comme le point de départ du corpus moderne, a été créé en 1964 et avait un million de mots ; le British National Corpus, de 100 millions de mots par mot, est de 1995 ; et il existe aujourd'hui un corpus de milliards de mots en anglais. En ce qui concerne les corpus parallèles qui comprennent l'anglais, le système de traduction automatique initié par Google en 2005 a été formé sur un corpus de 200.000 millions de mots.

En basque, par contre, le premier corpus (corpus textuel du Dictionnaire Général Basque d'Euskaltzaindia) a été élaboré en 1984 et se compose de 4,6 millions de mots. XX d'Euskaltzaindia. Le Corpus Statistique de l'Euskera du XXe siècle a pris fin en 2002 avec 6 millions de mots. La Fondation Elhuyar et le Groupe IXA de l'UPV ont lancé en 2006 le Corpus de Science et Technologie, avec 9 millions de mots. L'UPV-EHU a également réalisé la même année le corpus appelé Actualite de Prose Exemplaire, composé actuellement de 25,1 millions de mots. L'Observatoire du lexique d'Euskaltzaindia, lancé en 2010, compte actuellement 26,5 millions de mots. Quant aux corpus parallèles, les entreprises de traduction sont probablement les plus grandes dans leurs mémoires de traduction. Mais il y a très peu disponibles pour le public et disponibles en technologies linguistiques ; les mémoires de traduction des services de traduction de quelques institutions publiques (Service Officiel de Traduction de l'IVAP, Diputación Foral de Gipuzkoa, Diputación Foral de Bizkaia...) ou associations de vocation sociale (EIZIE, Librezale), et le corpus de revue

Solution Web

La recette pour résoudre ce problème était fournie par l'expert en corpus Adam Kilgarriff dans l'article mentionné ci-dessus: le web est la meilleure façon de composer les grands corpus d'une manière simple, économique et rapide. En fait, les gigantesques corpus des dernières années que nous avons évoquées en anglais se sont aussi formés ainsi, voyant que la formation de corpus de forme classique (en utilisant des éditeurs ou des médias) est beaucoup plus coûteuse et laborieuse.

Compléter les corpus automatiquement à partir du web a également ses contraires. Sa principale objection est qu'il y a beaucoup de textes de basse qualité. Mais d'un autre point de vue, c'est l'utilisation réelle de la langue courante et des corpus créés pour l'analyser. En outre, si les langues avec beaucoup plus de ressources ont été dirigées vers le web, c'est aussi pour le basque si vous ne voulez pas rester en arrière.

Portail de Corpus Web à Euskera

Ceux du groupe de R & D des technologies linguistiques de la Fondation Elhuyar travaillent depuis des années dans le domaine des corpus web, c'est-à-dire les corpus construits en utilisant des méthodes automatiques avec les textes du web. Nous avons travaillé sur des méthodes de compilation de différents types de corpus : corpus spécialisés en euskera (composés de textes d'un domaine particulier de connaissance), corpus multilingues comparables (composés de textes du même domaine de connaissance), corpus parallèles (composés de textes qui sont des traductions entre eux), corpus généraux gigantesques... Pour cela, il est nécessaire de développer d'autres techniques des technologies linguistiques : accès aux pages web avec certains mots des API des moteurs de recherche, connaissance de la langue d'un texte, détection de textes répétés ou très similaires, nettoyage des pages web (pour éliminer les pieds, en-têtes, menus de navigation, notes de copyright, etc. ), spam supplémentaire, détection de la zone de connaissance d'un texte, traduction de connaissances, etc.

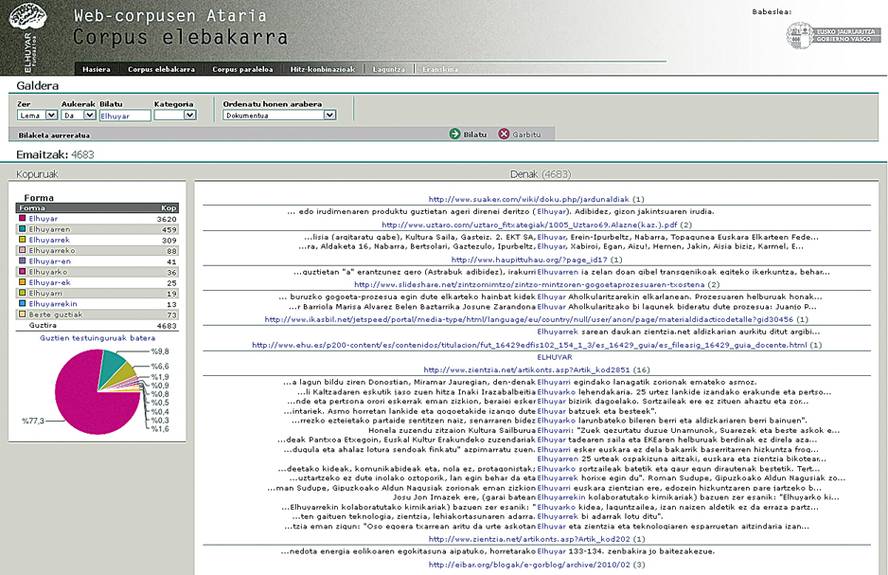

Grâce à ces outils, nous avons complété de nombreux corpus de tous les types mentionnés. Et maintenant, nous avons accroché certains de ces corpus en ligne sur le portail de Corpus Web: Un grand corpus général de 125 millions de mots en basque (le plus grand de ce type jusqu'ici) et un corpus parallèle euskera-castillan de 18 millions de mots (également le plus grand des corpus parallèles publics). Sur ces corpus, il est permis de réaliser différents types de recherches sur le web. Vous pouvez vous demander un slogan ou une forme déterminée ou le début ou la fin de ceux-ci, dans des combinaisons de trois mots à une distance maximale de 5 mots. En parallèle, vous pouvez demander des combinaisons de deux mots, mais vous pouvez les demander dans une, une autre ou les deux langues. Les deux sont très utiles pour voir comment les mots ont été utilisés ou traduits.

En outre, en appliquant des techniques linguistiques et des statistiques sur le corpus monolingue, on a calculé les trois combinaisons les plus utilisées (nom, nom, verbe et nom adjectif) et on a mis en consultation. De cette façon, nous pouvons demander au système avec quel verbe est généralement combinée un certain mot, avec quel adjectif, etc.

La publication du Portail de Corpus Web suppose un saut qualitatif, car c'est la première fois que sont mis à la disposition du public les corpus extraits automatiquement du web, ainsi que quantitatif, car il suppose une avancée significative dans la taille des corpus. Koldo Mitxelena disait que le vrai mystère de l'euskera n'est pas son origine, mais sa survie. Il est plus de mystère si elle restera dans l'avenir. Nous n'avons pas de réponse à cela, mais pour que l'euskera reste présent sans doute dans les technologies linguistiques. Chez Elhuyar, nous sommes convaincus que nous avons fait un pas de plus dans cette direction avec le portail web corpus.