Portal de Corpus Web: Gran almacén de textos en euskera realizados por Elhuyar I+D

Para una lengua es muy importante disponer de corpus textuales (colecciones de textos que sirven para realizar estudios lingüísticos). Son imprescindibles para la obtención de datos para la realización de estudios lingüísticos o para la toma de decisiones en la estandarización lingüística. Y son muy útiles también en la creación de textos o en la traducción: nos pueden explicar cómo se han utilizado o traducido palabras que no aparecen en los diccionarios o que no tienen ejemplos suficientes.

Pero, además, los corpus son de vital importancia en el mundo de las tecnologías lingüísticas. En los sistemas de reconocimiento de voz que traen los teléfonos móviles inteligentes de hoy en día, por ejemplo, se utilizan corpus para intentar inventar una palabra que no se ha entendido del todo bien, mirando en los corpus cuál es el más probable en ese contexto, o los sistemas de traducción automática, por ejemplo, utilizan corpus paralelos (corpus formados por textos que son traducciones recíprocas) para aprender, como te contamos en el número de noviembre de 2009.

Cuantos corpus más grandes mejor

En ese mismo artículo destacábamos que cuanto más grandes sean estos corpus mejor. Para consultar el uso de una palabra rara habrá más apariciones diferentes o más posibilidades de aparecer si el corpus es mayor. La traducción automática requiere también corpus de tamaño lo más grande posible, de ahí que Google sea referencia en la traducción automática multilingüe, ya que con los textos que indexa para el buscador se forman enormes corpus paralelos.

Como en muchos otros ámbitos, el euskera está muy por detrás de otras lenguas con más recursos, tanto en tamaño como en tiempo. Repasemos la situación del inglés: el corpus inglés Brown, que se considera el punto de partida de la moderna corpus, fue creado en 1964 y tenía un millón de palabras; el British National Corpus, de 100 millones de palabras por palabra, es de 1995; y en la actualidad existen corpus de miles de millones de palabras en inglés. En cuanto a los corpus paralelos que incluyen el inglés, el sistema de traducción automática iniciado por Google en 2005 se entrenó sobre un corpus de 200.000 millones de palabras.

En euskera, por el contrario, el primer corpus (corpus textual del Diccionario General Vasco de Euskaltzaindia) se elaboró en 1984 y consta de 4,6 millones de palabras. XX de Euskaltzaindia. El Corpus Estadístico del Euskera del siglo XX finalizó en 2002 con 6 millones de palabras. La Fundación Elhuyar y el Grupo IXA de la UPV lanzaron en 2006 el Corpus de Ciencia y Tecnología, con 9 millones de palabras. La UPV-EHU también realizó ese mismo año el corpus denominado Actualidad de Prosa Ejemplar, compuesto actualmente por 25,1 millones de palabras. El Observatorio del Léxico de Euskaltzaindia, puesto en marcha en 2010, cuenta en la actualidad con 26,5 millones de palabras. En cuanto a los corpus paralelos, las empresas de traducción probablemente son las más grandes en sus memorias de traducción. Pero hay muy pocos disponibles para el público y disponibles en tecnologías lingüísticas; las memorias de traducción de los servicios de traducción de algunas instituciones públicas (Servicio Oficial de Traducción del IVAP, Diputación Foral de Gipuzkoa, Diputación Foral de Bizkaia...) o asociaciones de vocación social (EIZIE, Librezale), y el corpus de la revista Consumer de Eroski, que están por debajo de 5 millones de palabras.

Solución web

La receta para solucionar este problema la proporcionaba el experto en corpus Adam Kilgarriff en el artículo antes mencionado: la web es la mejor forma de componer los corpus grandes de una forma sencilla, económica y rápida. De hecho, los gigantescos corpus de los últimos años que hemos mencionado en inglés también se han formado así, viendo que la formación de corpus de forma clásica (recurriendo a editoriales o medios de comunicación) es mucho más costosa y laboriosa.

Completar los corpus automáticamente desde la web también tiene sus contrarios. Su principal objeción es que en ella se pueden encontrar muchos textos de baja calidad. Pero desde otro punto de vista, ése es el uso real de la lengua actual y los corpus creados para analizarla. Además, si las lenguas con muchos más recursos se han dirigido a la web, eso también es para el euskera si no quiere quedarse atrás.

Portal de Corpus Web en Euskera

Los del grupo de I+D de las tecnologías lingüísticas de la Fundación Elhuyar llevamos años trabajando en el campo de los corpus web, es decir, los corpus construidos utilizando métodos automáticos con los textos de la web. Hemos trabajado métodos de recopilación de diferentes tipos de corpus: corpus especializados en euskera (compuestos por textos de una determinada área de conocimiento), corpus multilingües comparables (compuestos por textos del mismo campo de conocimiento), corpus paralelos (compuestos de textos que son traducciones entre sí), corpus generales gigantescos... Para ello es necesario desarrollar otras técnicas de las tecnologías lingüísticas: acceso a páginas web con ciertas palabras de los APIs de los buscadores, conocimiento del idioma de un texto, detección de textos repetidos o muy similares, limpieza de páginas web (para eliminar pies, encabezados, menús de navegación, notas de copyright, etc.), spam extra, detección del área de conocimiento de un texto, traducción de conocimientos, etc.

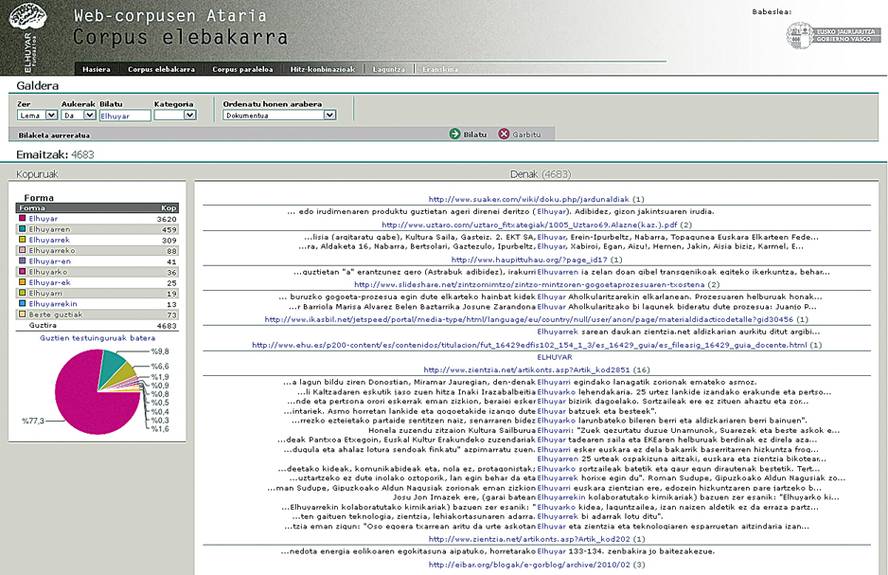

A través de estas herramientas hemos completado muchos corpus de todos los tipos mencionados. Y ahora hemos colgado algunos de estos corpus on-line en el Portal de Corpus Web: Un gran corpus general de 125 millones de palabras en euskera (el más grande de este tipo hasta ahora) y un corpus paralelo euskera-castellano de 18 millones de palabras (también el más grande de los corpus paralelos públicos). Sobre estos corpus se permite realizar diferentes tipos de búsquedas en la web. Pueden preguntarse por un lema o forma determinada o por el comienzo o terminación de los mismos, en combinaciones de hasta tres palabras a una distancia máxima de 5 palabras. En paralelo se pueden preguntar combinaciones de hasta dos palabras, pero se puede pedir que sean en uno, otro o ambos idiomas. Ambos son muy útiles para ver cómo se han utilizado o traducido las palabras.

Además, aplicando técnicas lingüísticas y estadísticas sobre el corpus monolingüe, se han calculado las tres combinaciones más utilizadas (nombre, nombre, verbo y nombre adjetivo) y se ha puesto a consulta. De esta forma podemos preguntar al sistema con qué verbo se suele combinar una determinada palabra, con qué adjetivo, etc.

La publicación del Portal de Corpus Web supone un salto cualitativo, ya que es la primera vez que se ponen a disposición del público los corpus extraídos automáticamente de la web, así como cuantitativo, ya que supone un avance significativo en el tamaño de los corpus. Koldo Mitxelena decía que el verdadero misterio del euskera no es su origen, sino su pervivencia. Es más misterio si se mantendrá en el futuro. Nosotros no tenemos respuesta a ello, pero para que se mantenga el euskera tiene que estar presente sin duda en las tecnologías lingüísticas. En Elhuyar estamos convencidos de que hemos dado un paso más en esta dirección con el Portal de corpus web.