Superant els nous límits d'AlphaGo mitjançant l'aprenentatge automàtic

Recentment han anunciat per primera vegada que ha estat capaç de guanyar a un jugador professional del joc de taula Go, molt conegut en Extrem Orient. És la primera vegada que en un joc d'aquestes característiques s'aconsegueix superar als éssers humans amb els mètodes denominats estudis automàtics. Però no serà l'últim.

En el camí cap a la intel·ligència de les màquines, és a dir , cap a la intel·ligència artificial, ha estat habitual tractar d'inventar màquines, programes o tecnologies que guanyin als éssers humans en tasques o jocs que s'han considerat complexos i merament aptes per a la realització de cervells humans. Així han anat caient una a una, límits que semblaven impossibles per endavant, i els ordinadors han anat superant a l'home en diversos jocs: en el joc de tres pastors, la màquina OXO, capaç de fer els partits perfectes en 1952 i assegurar almenys l'empat; en el joc de les dames, el programa Xinès va vèncer al millor jugador de tots els temps, en 1994 (i la màquina va aconseguir ser capaç de fer un partit perfecte per al Devoep en 2007); i el Debatut als jugadors en el Blonep.

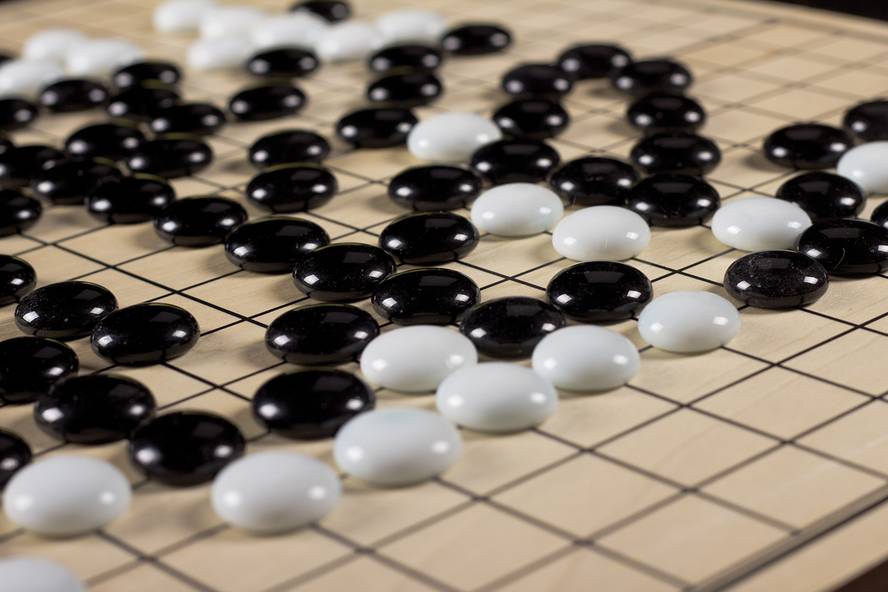

El joc Go era el següent repte a superar per les màquines. Encara que una cosa desconeguda al nostre país, està molt estès a la Xina i el Japó i compta amb més de 40 milions de jugadors en el món. Es juga en una taula del quadre 19x19 en la qual dos jugadors han de col·locar les fitxes negres i blanques per a anar guanyant les fitxes dels altres i acabar amb més fitxes que la resta. Un partit pot durar diversos dies, però en professionals els partits es limiten a 16 hores. Es calcula que en el joc Go poden donar-se unes 2x10170 combinacions possibles, més que el quadrat del nombre d'àtoms calculats en l'univers! I almenys 10100 vegades més combinacions que en escacs! A causa d'aquesta complexitat, els investigadors no aconseguien fer un programa que guanyés als jugadors professionals en el joc Go. Fins a octubre de l'any passat. Llavors, el sistema AlphaGo de Google va guanyar per primera vegada a un jugador professional Go.

Aprenentatge automàtic

En la història de la informàtica s'han utilitzat diverses maneres de resoldre problemes. De la forma més senzilla, els éssers humans codifiquen directament, en un programa, les decisions o jugades que s'han de prendre en cada situació en funció de les condicions. Això només serveix per als problemes més senzills, però en els inicis dels ordinadors no es podia fer una altra cosa. No obstant això, ha servit per a superar el joc de tres pastors i uns altres.

Una altra metodologia és la denominada “brute-force search”, és a dir, “cerca de força salvatge” o cerca combinatòria o profunda. A través d'ella, s'analitza a cada moment del partit a on poden portar totes les opcions possibles. No obstant això, en funció de la complexitat del joc, no es poden

analitzar les possibilitats de guanyar o no es pot arribar a la profunditat mínima necessària. Per exemple, cal estudiar un milió d'oportunitats per a arribar a la profunditat de 4 jugadors, un bilió d'opcions per a 8 jugadors, un trilió per al 12… No obstant això, aquest tipus de sistemes s'han utilitzat molt i amb èxit. Deep Blue, en definitiva, utilitzava aquest mètode. Però aquest sistema de joc Go té les seves limitacions, ja que a cada moment es poden realitzar al voltant de 250 possibles jugades.

Per això, el sistema més utilitzat en els últims temps per a resoldre aquest tipus de jocs, així com molts altres problemes complexos, com molts dels relacionats amb la tecnologia lingüística i de veu, és l'aprenentatge automàtic. En l'aprenentatge automàtic es combinen diferents metodologies amb un mateix funcionament: existeixen determinades estructures de dades que proporcionen unes entrades que proporcionen unes sortides; a aquestes estructures se'ls donen molts exemples per a les entrades i les sortides que necessitarien i a través d'uns algorismes adapten la seva estructura per a donar les sortides que es desitgen aconseguir. Per exemple, en els escacs les entrades poden ser els estats del tauler i les sortides, les millors jugades per a aquestes situacions. Si s'aconsegueix adaptar les estructures de dades per a donar aquestes sortides enfront d'aquestes entrades, en la majoria dels casos seran capaços de donar una resposta òptima fins i tot en situacions noves que mai se'ls havia mostrat anteriorment.

En l'aprenentatge automàtic es van utilitzar inicialment estructures de dades anomenades neural network o xarxes neuronals que intenten imitar el comportament de les neurones dels cervells humans. En la dècada dels 70 la recerca en intel·ligència artificial es va allunyar d'aquests sistemes, però a la fi de la dècada de 2000 es va ressorgir l'interès per les xarxes neuronals, que són àmpliament utilitzades. El sistema AlphaGo que ens ocupa està basat en xarxes neuronals. A la vista de l'evolució dels últims anys i dels resultats obtinguts amb el joc de Go, sembla que en els pròxims anys les recerques sobre la intel·ligència artificial avançaran cap a un aprenentatge automàtic.

...i més enllà!

L'interès per l'aprenentatge automàtic i les xarxes neuronals s'ha ressorgit perquè els potents ordinadors actuals han permès estructures de dades o xarxes neuronals més complexes. En concret, en el cas de les xarxes neuronals, ara les neurones artificials poden dividir-se en múltiples capes, utilitzar moltes més dades per a entrenar o aprendre i donar solució a problemes complejos.se criden Deep neural network o xarxes neuronals profundes, i AlphaGo utilitza una d'aquestes característiques.

Però una xarxa de neurones d'aquestes característiques per al joc Go, malgrat entrenar amb 30 milions de jugadors humans, no van aconseguir tan bons resultats. Una altra tècnica utilitzada va ser la reinforcement learning. En aquest mètode, el sistema obtingut es posava a jugar contra si mateix, molts partits, i posteriorment s'utilitzaven els moviments d'aquests partits per a entrenar i millorar el sistema mitjançant l'aprenentatge automàtic. I una vegada fet això, van aconseguir construir AlphaGo.

Això significa que per a fer un jugador artificial s'ha utilitzat un sistema d'aprenentatge automàtic, però no per a aprendre dels humans, sinó per a aprendre de si mateix! Els estudis inicials s'han realitzat a partir de partides humanes. Però funcionaria sense ells? És a dir, si amb una màquina de partida molt naïf o aleatòria i jugant partits amb si mateixa, ens poséssim a aprendre i a millorar constantment, el resultat seria el mateix? En aquest cas, les conseqüències serien enormes.

En qualsevol cas, a l'octubre, el jugador que va ser derrotat pel sistema AlphaGo, Fan Hui, és un jugador professional de 2 d??s malgrat ser campió d'Europa. A mitjan març, el sistema AlphaGo s'enfrontarà a Lee Es-dol, un dels millors jugadors de la història i amb un rànquing de 9 dans (màxim existent) en el partit públic que se celebrarà a Corea del Sud. El seguiment del partit serà sens dubte de gran interès.