La masse perdue de l'univers

Cette théorie explique l'expansion de l'univers découverte par Hubble à la suite d'une explosion initiale. La loi de gravité est le contrepoint de l'expansion, qui fonctionne en réduisant la vitesse d'éloignement entre tous les objets. L'analyse de ces effets indésirables suggère une question à venir: L'expansion de l'univers sera-t-elle maintenue indéfiniment ou l'influence de la gravité paralysera-t-elle l'expansion et provoquera-t-elle un autre effondrement semblable au moment de sa création ?

La réponse est liée à la quantité de materi de l'Univers. La valeur minimale de la densité pour que la gravité arrête l'expansion est appelée densité critique et est exprimée par c. Bien sûr, plus la vitesse de propagation est élevée, plus les valeurs nécessaires à la densité critique sont élevées. Par conséquent, il est calculé à partir des mesures des vitesses d'éloignement des galaxies c et la valeur admise aujourd'hui c = 2. 10 – 29 g/cm 3, soit environ 10 atomes d'hydrogène par mètre cube.

Si la valeur de la densité actuelle de l'univers était une valeur critique ( c ), nous devrions supposer que l'univers est infini, sa géométrie étant une géométrie euclidienne typique, c'est-à-dire une géométrie plane. Dans ce cas, la force de gravité paralyserait la propagation, mais ne pourrait pas provoquer l'effondrement ultérieur. Si la densité actuelle est supérieure à c, l'Univers serait fini, la géométrie sphérique — la distance la plus courte entre deux points ne serait pas une droite, mais un arc de circonférence — et suivrait l'effondrement de l'expansion.

Si nous n'atteignions pas la valeur critique 0, nous vivrons dans un Univers infini et une géométrie hyperbolique. Ces options sont généralement indiquées par le paramètre 0 = 0 / c. La première option, celle de l'univers plat, correspond évidemment au cas 0 = 1, celle du sphérique à 0 1-i et celle de l'hyperbolique à 0 1-i. Par conséquent, il est très important d'obtenir des mesures fiables de la densité et au cours des dernières années, les imprévus ont eu lieu à partir des sessions effectuées pour cela.

Le soupçon qu'il ya plus de choses que vous pouvez voir et détecter dans l'univers par télescopes et radiotélescopes n'est pas le courant. J. Oort en 1930 et F. Zwicky” a proposé en 1933 la nécessité d'une matière invisible pour expliquer certains mouvements du système. Cependant, ce que personne ne s'attendait à ce que la matière que nous avons pu détecter à travers sa divination ne soit que le centième de l'univers. Cependant, les théories actuelles vont sur cette voie. L'existence d'une grande quantité de masses non détectées génère des problèmes sur leur nature, consolidant l'hypothèse que la matière peut être non varionique. Autrement dit, ce vide qui est devenu évident ne serait pas celui des protons, des neutrons (barions) et des électrons globaux connus, mais d'autres fractions spéciales générées dans les premiers pas de l'évolution de l'univers.

Les bases expérimentales qui soutiennent ces conclusions ont été obtenues au niveau des galaxies et des amas de galaxies. D'autre part, au niveau cosmologique, certains calculs basés sur les théories que nous considérons bien établies renforcent les conclusions suggérées par ces mesures.

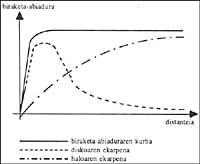

Quant aux bases expérimentales, le premier test est fourni par les mesures du mouvement de rotation des galaxies. Selon eux, la vitesse de rotation des nuages d'hydrogène situés à l'extérieur des disques des galaxies (jusqu'à 30 kiloparsec) n'est pas inférieure à celle des étoiles et des nuages intérieurs, comme le prévoit la loi gravitationnelle de Newton. Comme on peut l'apprécier dans la figure, il est décrit par une courbe qui évolue à vitesse lente, forçant l'existence d'une influence qui serait manifestée par une telle masse existante.

Selon les valeurs obtenues, la masse d'une galaxie commune multiplierait ce que nous avons détecté grâce à son émission électromagnétique, c'est-à-dire que nous ne percevons pas 90% de la masse des galaxies. Si seulement la masse que nous avons pu voir existait dans l'Univers, la valeur de la densité serait de 1% ou de 2% de celle nécessaire pour que l'Univers se produise. En acceptant l'augmentation de masse nécessaire pour expliquer la vitesse de rotation des galaxies, il se situerait entre 10% et 20% de la valeur critique 0.

En analysant les amas et les superamas, les résultats sont similaires. Bien que l'on considère comme une masse de galaxies la nécessaire pour expliquer la vitesse de rotation, l'analyse dynamique de ces structures révèle que pour expliquer la stabilité des amas et des superamas qui est devenu évident par d'autres voies, il faut plus de masse que celle qui suppose la contribution des galaxies.

Compte tenu de ces résultats, on peut penser qu'il y a une erreur systématique dans le processus de mesure, mais c'est un argument théorique très important qui affirme la fiabilité des résultats expérimentaux.

Dans les premières épingles de l'évolution de l'univers sont apparus les éléments les plus légers par des processus de nucléosynthèse. Les quantités d'éléments qui ont ensuite été formés dépendaient logiquement du nombre de protons et de neutrons qui existaient sur place. Compte tenu de cela, l'abondance relative à l'hydrogène de ces éléments actuels permet de limiter l'abondance des barions par heure. Comme cette quantité est constante, vous pouvez calculer la densité que vous générez actuellement. En mettant des nombres on obtient que la densité de la matière commune se situe autour de 20% de c.

Avec ce qui est dit dans les derniers paragraphes, et même si la quantité de masse nécessaire pour expliquer la dynamique des galaxies et des amas est très grande, un univers ouvert et hyperbolique peut être admissible, avec une matière non visible aussi commun, mais cette hypothèse ne peut pas être maintenue dans le panorama que décrivent les théories cosmologiques.

Année 1980 A. H. Sur la base des nouvelles théories des fractions, Guth a ajouté au big-bang une profonde amélioration, expliquant le problème de la laïcité entre autres succès. Aujourd'hui, l'Univers, jusqu'aux limites que nous connaissons, est quatre, et nous avons des preuves de ce qui a été jusqu'ici ainsi, mais selon le modèle big-bang si la valeur initiale de W n'avait pas été 1, il aurait été loin de la valeur de l'évolution de l'Univers, faisant une courbure évidente. Selon la théorie de l’univers inflationniste (souvent appelée théorie de Guth), l’univers a élevé 10 fois son volume (donc la référence à l’inflation) à un stade très précoce et bref de son évolution (t = 10 – 35” d’abord et 10 – 32” de durée).

Cet énorme élargissement a fait disparaître presque complètement la courbure de l'Univers, comme diminue quand nous gonflons un globe. Par conséquent, la valeur a été fait pratiquement un et le changement qu'il a subi depuis n'est pas suffisant pour être évident. Nous devons donc reconnaître que 0 = 1, c'est-à-dire 0 = c, que l'univers est plat et qu'au moins 80% de la matière présente n'est donc pas formée de protons et de neutrons.

Il est temps d'aborder directement le sujet que nous avons déjà mentionné dans le titre, en répondant à deux questions principales. Un sur la distribution de cette matière froide et un autre, bien sûr, sur sa nature.

Quant au premier, les chercheurs ont sérieusement envisagé le choix que les galaxies ne soient pas représentatives des plus grandes condensations de matière. Selon les données que nous avons données ci-dessus, la masse des galaxies ne compte que 20% de c. Par conséquent, 80% suffisant pour que l'univers se produise serait dans des régions où il n'y a pas de galaxies.

Sur la nature, nous ne pouvons pas dire trop de choses concrètes. Le problème est assez inconnu pour qu'il y ait beaucoup de candidats. Peut-être ce qui peut être affirmé avec une plus grande certitude est l'inadéquation des candidats (neutrinos) mentionnés ci-dessus. Le principal motif de l'exclusion est que, après avoir formé des superamas et des amas dans un univers rempli de neutrinos, la galaxie prendrait beaucoup de temps à se condenser, finalisant le processus avec la moitié de l'âge de l'univers. L'existence de structures anciennes comme les quases nie la validité de l'hypothèse.

Tous les autres candidats présentent une erreur initiale importante: que leur existence soit purement théorique. Du reste, il semble que certains d'entre eux pouvaient être suffisants pour occuper la place de la matière froide non perçue. La plupart sont des besoins des théories de la physique des fractions et peuvent être classés en deux grands groupes : les bosons légers, c'est-à-dire les fractions légères de tout le spin (entre 10 – 14 et 10 – 10 de sa masse protocolaire) et les fractions lourdes (de la masse intermédiaire entre 1 et 1000 du proton).

La fraction du premier groupe auquel on a donné plus d'options est l'axio. Cette fraction est une nécessité créée par une symétrie existante entre les interactions principales à des niveaux élevés d'énergie. Ces axions, en brisant la symétrie, créeraient une zone de fond (semblable au rayonnement des micro-ondes de fond) pour une accumulation ultérieure en grands groupes, expliquant la matière perdue. Parmi ceux du deuxième groupe, les plus prestigieux sont les dérivés de la théorie de la supersymétrie. La supersymétrie est une nouvelle symétrie qui relie les fermions (fractions d'une demi-épine, par exemple protons neutrons et électrons) et les bosons (plein spin, comme le photon et le gluon).

Ceci unifierait les quatre interactions principales connues (électromagnétique, faible, violent et pesanteur) en une seule et prédit une nouvelle pour chaque fraction connue jusqu'ici : fotine, gravitine, électron, selectron, neutrino, sneutrino, etc. Parmi eux, on peut citer le gravitino et le fotino. Les gravitinos, contre le cas du neutrino, peuvent expliquer la formation de galaxies, mais pas celle de superamas. Les fotins avec une masse intermédiaire entre les périodes 1 et 50 de la masse du proton pouvaient aussi faire partie de la masse perdue, mais pour eux il y a aussi des difficultés non surmontées.

Enfin, mentionner deux nouveaux candidats: monopoles magnétiques et cordes de big-bang. Ce ne sont pas des fractions, mais des erreurs topologiques produites dans les premières étapes de l'évolution de l'univers. Mais dernièrement, on a beaucoup parlé de ces créatures. Par conséquent, dans le prochain numéro, nous analyserons plus en profondeur.