Red neuronal artificial

Desde el punto de vista de la cibernética, además de las técnicas de procesado utilizadas en los ordenadores digitales más conocidos, aparecen otras posibilidades. Una de las direcciones que más se está investigando es la posibilidad de desarrollar sistemas de procesamiento que utilicen los mismos principios de comportamiento y estructuras que pueden encontrarse tanto en el ser humano como en otros seres vivos. Esto ha creado nuevos ordenadores: neuroordenadores. Hay una diferencia importante entre ambos.

Los ordenadores digitales son sistemas secuenciales diseñados para manejar las manifestaciones simbólicas de todo lo que se encuentra en el exterior. Por otra parte, los neuroordenadores son sistemas de estructura paralela que procesan directamente la información externa, es decir, sin utilizar apariciones simbólicas. Para comprender lo que está detrás de la neuroconputación, es muy interesante entender los principios de la neurobiología y su importancia en la computación superrápida.

Fundamentos de la neuroconputación

Las neuronas son células nerviosas y las redes neuronales son redes formadas por estas células. El cerebro es un ejemplo natural de redes neuronales. El interés que siempre ha existido por las redes artificiales NSA (Redes Neuronales Artificiales) se basaba en consideraciones anatómicas y psicológicas. Los primeros modelizadores de neuronas artificiales trataron de mostrar la relación estímulo/respuesta de las neuronas biológicas y además la estructura interna de las neuronas.

Es decir, en el campo de la física y la ingeniería las más destacadas fueron las “características computacionales” de las neuronas. El interés de los que trabajan en los ámbitos de la lógica, las matemáticas, la ciencia de la computación y la física por este problema ha ido creciendo y disminuyendo a lo largo de los años, pero en la actualidad está en un nivel alto. Esto se debe a la creación de poderosos ordenadores que resuelven problemas que no se pueden resolver con los sistemas de computación utilizados hasta ahora.

Conceptos biológicos básicos

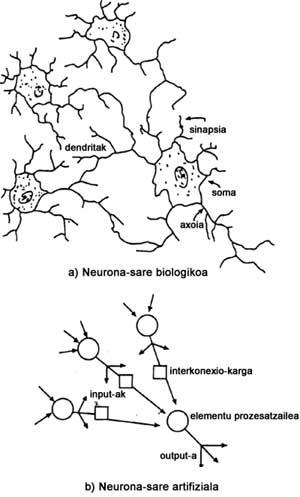

Actualmente sabemos que la anatomía de una neurona biológica es:

- Estructura de cuernos, con células denominadas dendritas, que se considera zona de recepción de señales desde otras neuronas.

- Cuerpo de la célula, llamado soma.

- Larga estructura de transmisión lineal denominada axon.

- Estructuras tipo brocha, llamadas botones sinápticos, situadas al final de la cola de Axon.

1º. En la figura se presentan las estructuras de una neurona biológica mencionada. 1.b. la imagen presenta la abstracción matemática de la neurona. En esta imagen x 1 , x 2 , ..., x n , j son entradas que llegan a la neurona, w ij , resistencias sinápticas y y j , salida de la neurona. 1.c. en la figura 1.b se muestra el circuito eléctrico correspondiente a la abstracción matemática de la figura. En este caso cada x i es tensión y w ij , cada uno se presenta con un potenciómetro. El triángulo con signo aditivo en su interior es un amplificador operacional configurado en forma aditiva. La cantidad f será cualquier función no lineal.

2º. En la imagen se puede ver una red de neuronas biológicas. Cuando dos neuronas de esta red están muy próximas, se llama sinapsis al punto de unión. La influencia de las neuronas en el punto de contacto es electromecánica. La sinapsis no es un contacto físico real. Una señal se comporta como un sistema de encendido, es decir, no pasa información hasta que la concentración de la señal supera un límite. Cuando esto ocurre, se genera potencial en la célula receptora de información.

Cuando una neurona toma información a través de contactos sinápticos desde los laterales, la toma se realiza mediante pulsos consecutivos. Entonces se realiza la suma explorada de las entradas algebraicas, se computa la función de contención de dicha suma y se crea la salida (si el valor de la función supera el valor límite). Como en los contactos sinápticos la transmisión se realiza en una sola dirección, los pulsos de entrada y salida van de las dendritas a la somara, de aquí a axon y finalmente a los botones sinápticos. Dado que los mecanismos básicos de computación de las neuronas biológicas son la suma ponderada y la función de contención, trataremos de emular estas funciones biológicas mediante redes NSA.

Se ha estimado que el cerebro humano tiene un número de neuronas entre 109 y 1012, existiendo entre ellas más de 1015 contactos sinápticos. Estas células son unidades de procesamiento de información cerebral básica. Además, se ha estimado que una neurona normal recibe información de otras 10.000 neuronas y la envía a 1.000 neuronas si es necesario. A pesar de conocer el comportamiento de las neuronas raras y las conexiones entre las neuronas, se desconoce su comportamiento cuando los grupos neuronales trabajan juntos.

Por tanto, lo mejor que podemos hacer es considerar que, siguiendo la misma estructura, el comportamiento de las redes artificiales también será de alguna manera similar. Es imposible seguir completamente esta estructura. Sin embargo, al tratarse de una red que cumple funciones muy especiales, la NSA puede tener una estructura más sencilla que la neurona biológica. Además, está demostrado que el procesamiento de la información que se produce en el cerebro no es sólo paralelo, sino que también hay funciones bien situadas.

Según las informaciones extraídas de neuropatología, neurohistología y neurofarmaquología, la parte máxima de la computación se produce en aproximadamente 1.000 zonas (módulos). Por ejemplo, la capacidad de hablar está asociada a la zona de Broca en el lóbulo frontal izquierdo del cerebro, mientras que la capacidad de comprender el lenguaje natural está asociada a la zona de Wernick, situada en la parte trasera del lóbulo temporal y a la izquierda. Por lo tanto, se puede decir que las operaciones de alto nivel se realizan en ámbitos especiales, en los que se comunica de alguna manera. Se considera que los componentes que intervienen en el procesamiento de la información son el cerebelo, el hipocampo, las amígdalas y la corteza cerebral.

Todo ello nos lleva a pensar que el cerebro humano es una estructura zonificada en función de las funciones, en la que el procesado se realiza de forma paralela. Además, parece que el trabajo paralelo de las neuronas se realiza asíncronamente, es decir, sin centro de sincronización (sin reloj). Por estos motivos, muchos piensan que a través de los grupos que realizan el procesado de forma paralela (realizando asíncronamente la comunicación entre ellos y la distribución de funciones), la red neuronal aparecería mejor.

Funcionamiento de las redes

El proceso de computación a través de redes NSA es el siguiente: (NA) Una “neurona artificial” (o (PE) elemento de procesamiento recibe las entradas de otro NA o de un estímulo externo. La suma agitada de estas entradas completa el argumento de la función activadora (o de transferencia). Esta función que define las características de la neurona normalmente no es lineal. El resultado de la función activadora es la salida de n. Esta salida se divide a lo largo de las conexiones de otro DNI.

El modo en que se realizan estas conexiones (es decir, topología) define el flujo de información que se produce a través de la red y se denomina arquitectura de la red. Las configuraciones arquitectónicas más utilizadas son las de una capa, multicapa, realimentación, prealimentación y conectividad lateral. La importancia de las conexiones agitadas en estas arquitecturas es muy elevada, por lo que son conocidas como modelos de computación conectiva.

El proceso de acondicionamiento de los pisos durante la preparación de la red se denomina regla de aprendizaje. Es decir, los sistemas de redes neurales artificiales no se programan, se les enseña. Este proceso de aprendizaje puede ser auditado o no auditado. La más utilizada en las reglas de aprendizaje auditadas es el método de programación hacia atrás (BP). Un método no auditado pertenece a la auto-organización. En resumen, los tres componentes fundamentales de los sistemas de computación basados en redes NSA son la función de transferencia, la arquitectura y la regla de aprendizaje. Hay que decir que este tipo de modelos de computación tienen sólo la apariencia metafórica de los cerebros reales.

Cuando se obtenga un modelo computacional adecuado, la implantación del sistema puede realizarse mediante la utilización de componentes digitales, ópticos o analógicos de computación como bloque de operaciones. Un componente conocido entre los ingenieros eléctricos, que se comporta de alguna manera como las neuronas, es un amplificador operacional configurado como integrador. Si se supervisa un centenar de integradores conectados entre sí por potenciómetro (los potenciómetros son sinapsis), se puede analizar como una primera aproximación de una NSA.

La adaptación de estos potenciómetros a la representación del algoritmo de aprendizaje permitiría una mejor aproximación a la red neuronal. Cualquiera que conoce el funcionamiento de la computación analógica sabe que esta configuración de computación (y por tanto el modelo matemático de descripción de la red neuronal) está constituida por un grupo de ecuaciones diferenciales no lineales y acopladas. Es decir, los NSA se pueden ver como sistemas dinámicos que se programan. Por tanto, el proceso de aprendizaje, mientras el sistema dinámico alcanza un estado de mínima energía, puede aparecer como un proceso de adaptación de parámetros (coeficientes de ecuaciones diferenciales). De esta forma, se puede utilizar más ampliamente las matemáticas.

A pesar de que la descripción dada anteriormente cuenta con una buena presentación de la neurona artificial y de la NSA, la definición de NSA todavía no puede ser perfectamente definida. La NSA puede definirse como un sistema de computación distribuida con múltiples componentes de procesamiento interconectados. Otra definición es que la NSA es un sistema adaptador y paralelo con capacidad de autoaprendizaje, capaz de procesar la información.

Diferencias entre neuronas biológicas y artificiales

Para comprender mejor lo anterior, se presentarán las diferencias existentes entre redes de neuronas biológicas y neuronas artificiales:

- Los componentes electrónicos utilizados para simular neuronas son muy rápidos, pero con poca conexión. Las neuronas biológicas son unidades analógicas conectadas con alta densidad. Siendo las constantes de tiempo de estas unidades milisegundas, el trabajo de las neuronas reales es más lento que el de las artificiales. Las neuronas artificiales crean escalares de salida de medida media de los pulsos producidos por las neuronas biológicas. Cuando se transmite un pulso de una neurona a otra, se hace a velocidad lenta, oscilando entre 0,5 y 120 metros en un segundo. Según estos parámetros, no se puede saber cómo puede realizar el cerebro todos los trabajos anteriormente mencionados en tiempos cortos medidos. Sin embargo, hay muchos investigadores que están desarrollando modelos para realizar funciones cerebrales.

- Una neurona biológica hace trabajar o frenar a las neuronas que están en contacto con él, pero ambas cosas no pueden hacerse juntas. Esto se dice que es la ley de Eccles. Parece que los sistemas NSA no se siguen a esta regla.

- El código de información del sistema nervioso real difiere del utilizado por el sistema NSA. Por ejemplo, cuando una neurona biológica produce una salida, ésta es un grupo de pulsos consecutivos. La frecuencia de esta salida se relaciona de forma logarítmica con la suma algebraica de las entradas que llegan a la neurona. Esta frecuencia es de 1 a 100 ciclos por segundo aproximadamente. Esto indica que los bits utilizados en la transmisión de información entre neuronas son muy escasos.

- Por último, parece que los cerebros reales son estructuras de computación superficial, es decir, con muy pocas capas, con un alto grado de similitud. Por otra parte, los modelos basados en ordenadores digitales convencionales son secuenciales y tienen una estructura computacional profunda.

Futuro

En la actualidad existen áreas en las que estas redes neuronales están aplicando con éxito: visión artificial, traductores de lenguajes naturales, etc.

Sin embargo, tanto el proceso de aprendizaje de estas redes como los problemas asociados a su densidad, todavía no han sido superados. Por otra parte, con la tecnología VLSI (very large scale integration) y los avances que se están produciendo en óptica, optoelectrónica y tecnología holográfica, parece que se van a dar solución a estos problemas.

De este modo, la revolución tecnológica que estos nuevos tipos de ordenadores, formados por redes neuronales y no digitales, van a influir en nuestra vida diaria será enorme: sistemas de seguridad, sistemas de control de calidad, ámbito médico, etc.